Squarespace robots.txt: Ein Leitfaden

Eine robots.txt-Datei hilft euch, zu steuern, wie Web-Crawler und Bots mit den Inhalten auf eurer Website interagieren. Squarespace hat bislang dieselbe robots.txt-Datei für alle Websites verwendet. Seit allerdings KI-Bots immer präsenter geworden sind, haben sich viele Squarespace-Nutzer:innen die Möglichkeit gewünscht, KI-Crawler explizit am Scannen ihrer Seiten zu hindern.

Im August 2023 wurde der Crawler GPTBot vorgestellt, der zum Training des Sprachmodells eingesetzt wird. Größere Webseiten blockierten daraufhin die KI-Bots, die Inhalte zu Trainingszwecken crawlen. Squarespace führte im Oktober 2023 eine Option ein, die es ermöglicht, KI-Crawler und / oder sämtliche Suchmaschinen-Crawler zu blockieren.

Im Folgenden erklären wir euch, was das für eure Squarespace-Seite bedeutet und wie ihr die robots.txt-Datei anpassen könnt.

Was ist eine robots.txt?

Robots.txt ist eine Textdatei, die im Stammverzeichnis einer Website liegt. Sie gibt Web-Crawlern und Bots Anweisungen, welche Seiten und Dateien sie crawlen dürfen und welche nicht. Eine robots.txt-Datei ist keine verbindliche Anweisung, aber seriöse Crawler befolgen in der Regel deren Vorgaben.

Einsehen könnt ihr die Datei über

folgende Anweisung im Browser: eurewebsite.de/robots.txt

den Google robots.txt Report, wenn ihr eure Website mit der Google Search Console verknüpft habt

Hauptsächlich dient die robots.txt-File dazu, eine Überlastung eurer Website zu verhindern und den Crawler-Traffic zu steuern – nicht, um Seiten vollständig zu verbergen. Seiten, deren Zugang über die robots.txt gesperrt wurde, können trotzdem indexiert werden.

Möchtet ihr eure Seite vollständig aus den Suchergebnissen ausschließen, solltet ihr diese durch ein Passwort schützen oder den noindex-Tag nutzen.

Lesetipp: Welchen Einfluss KI auf SEO hat, erfahrt ihr in unserem Beitrag über den Google AI Mode.

Robots.txt-Syntax und Beispiele

Squarespace lässt seine Nutzer:innen die robots.txt-Datei nicht direkt bearbeiten. Trotzdem hilft ein Grundverständnis der Syntax, um Änderungen zu verstehen und zu überprüfen.

Eine robots.txt-Datei besteht aus den folgenden Bestandteilen:

User-agent: Spezifiziert, für welchen Web-Crawler die Anweisungen gelten, beispielsweise GPTBot. Mit der Anweisung "User-agent: *" werden alle Web-Crawler angesprochen.

Disallow: Gestattet das Auslesen einer Seite / Datei nicht. Die Anweisung "Disallow: /" verbietet das Auslesen der gesamten Website.

Allow: Gibt an, auf welche Seiten / Dateien zugegriffen werden darf.

Beispiel 1: Möchtet ihr als Online-Händler:innen beispielsweise den Google Bot vom Zugriff auf Benutzerkonten ausschließen, solltet ihr folgende Anweisungen in eurer robots.txt hinterlegen:

User Agent: GoogleBot

Disallow: /account/

Beispiel 2: Möchtet ihr, dass eure Inhalte nicht für Large Language Models (LLMs) wie ChatGPT sichtbar sind, könnt ihr entsprechende Bots (z. B. den GPTBot von Open AI) blockieren.

User Agent: GPTBot

Disallow: /

Liste der blockierten KI-Crawler in der Squarespace robots.txt-Datei

Squarespace gibt euch die Möglichkeit, entweder alle KI-Bots oder gar keine auszuschließen. Das Unternehmen aktualisiert die Liste der blockierten KI-Bots regelmäßig. Stand November 2025 könnt ihr über die Einstellungen folgende Crawler blockieren:

Amazonbot

Anthropic AI

Applebot-Extended

CCBot

Claude-Web

ClaudeBot

cohere-ai

DuckAssistBot

FacebookBot

Google-CloudVertexBot

Google Extended

GPTBot and ChatGPT-User von Openai

Meta-ExternalAgent

PerplexityBot

Quora-Bot

Auswirkungen des Ausschlusses von KI-Bots

Der Ausschluss von KI-Crawlern beeinflusst die Sichtbarkeit in neuen, KI-gesteuerten Suchsystemen (z. B: ChatGPT, Perplexity, Claude usw.). Wenn euer Content blockiert ist, können diese Systeme eure Website weder referenzieren noch zitieren. Das bedeutet, dass eure Marke in der KI-Suche komplett verschwinden kann.

Das Blockieren von KI-Bots hat dabei keine Auswirkungen auf klassisches SEO. Googlebot und Bingbot bleiben weiterhin zugelassen, sodass eure Inhalte von den klassischen Suchmaschinen ausgelesen und indexiert werden können.

Ihr braucht Hilfe bei der Suchmaschinenoptimierung? Kontaktiert uns für ein SEO-Audit eurer Squarespace-Seite!

Squarespace robots.txt anpassen

Welche Systeme ihr von eurer Website ausschließt und wie ihr mit den KI-Bots umgeht, müsst ihr letztlich selbst entscheiden. Diejenigen, die ihre Inhalte neben den klassischen Suchmaschinen auch in der KI-Suche platzieren wollen, sollten den Zugang zur Website nicht ausschließen. Im Folgenden zeigen wir euch, wie ihr eure robots.txt anpassen könnt.

Ein-Klick-Lösung über Squarespace

Squarespace gibt euch die Möglichkeit, das Crawling eurer Inhalte zu kontrollieren. So passt ihr die robots.txt-Datei in Squarespace an.

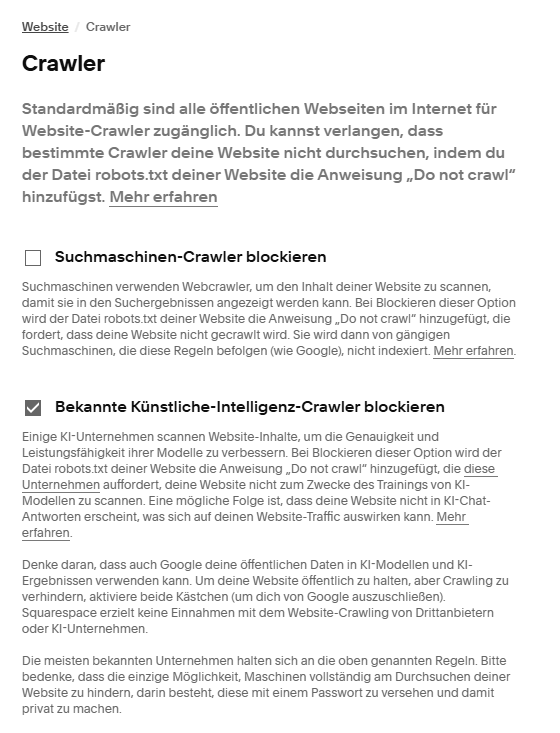

Geht in Einstellungen → Website → Crawler und wählt die gewünschten Optionen. Eine Checkbox schließt Suchmaschinen-Crawler aus, die andere blockiert KI-Crawler. Ihr habt damit folgende Optionen:

Standarddatei: Wenn keine Option aktiviert ist, gilt die standardisierte robots.txt-File von Squarespace – alle Crawler sind erlaubt.

Nur KI blockieren: Die bekannten KI-Crawler dürfen eure Seite nicht scannen.

Nur Suchmaschinen blockieren: Schließt Suchmaschinen und Googles AdsBots aus.

Beides blockieren: Verhindert das Crawlen durch alle aufgeführten KI-Bots, AdsBots und alle weiteren Bots, die robots.txt respektieren.

Umweg über GitHub

Ihr habt die Möglichkeit, eine eigene robots.txt-Datei auf GitHub zu erstellen. Erstellt dafür erst ein kostenloses GitHub-Konto. Legt anschließend ein Repository an mit dem Namen euerusername.github.io. Fügt darin eine Datei mit dem Namen robots.txt und dem folgenden Inhalt hinzu:

User-agent: GPTBot

Allow: /

User-agent: ClaudeBot

Allow: /

User-agent: *

Disallow: /config

Disallow: /search

Allow: /

Sitemap: https://www.euredomain.com/sitemap.xml

Host: www.euredomain.com

Diese Datei ist anschließend erreichbar unter: https://euerusername.github.io/robots.txt

In Squarespace geht ihr anschließend zu den Einstellungen → Erweitert → URL-Mappings und fügt Folgendes hinzu:

/robots.txt -> https://euerusername.github.io/robots.txt 301

Squarespace setzt diese Weiterleitung möglicherweise nicht sofort um, sie funktioniert aber in den meisten Fällen für Crawler, die Links folgen.

KI-Zugriff erlauben auf HTML-Level

Ihr könnt zwar über Squarespace die robots.txt-Datei nicht direkt bearbeiten und ändern, jedoch befolgen viele KI-Crawler Meta-Tags. Ihr könnt dementsprechend Meta-Tags im Header hinzufügen. Geht dazu in die Einstellungen → Erweitert → Code Injection → Header und fügt diesen Code ein:

<meta name="robots" content="index, follow, max-snippet:-1, max-image-preview:large, max-video-preview:-1">

Damit erlaubt ihr KI-Crawlern, eure Inhalte zu indexieren und euren Anweisungen zu folgen, selbst wenn robots.txt andere Angaben enthält.

Welche Websites blockieren Suchmaschinen?

Wenn eure Website auf Reichweite abzielt, bietet es sich nicht an, Crawler zu blockieren. Allerdings gibt es Seiten, die für die nicht-öffentliche Nutzung gedacht sind, wie etwa private Websites oder interne Unternehmensseiten. Diese profitieren von der Blocking-Funktion, sollten aber in jedem Fall auch passwortgeschützt sein.

Solltet ihr KI-Crawler blockieren?

Ob ihr KI-Crawler in eurer Squarespace robots.tx-File blockieren solltet, hängt ganz von euren Zielen ab. Um eure Inhalte und euer Urheberrecht (bspw. als Künstler:innen) zu schützen und um zu verhindern, dass eure Seite zum Training von KI-Modellen genutzt wird, ist ein Blockieren der KI-Bots angebracht. Jedoch schränkt dies auch eure Reichweite und Sichtbarkeit signifikant ein. Um eure Seite für die Suchmaschinen zu optimieren, empfiehlt es sich also, die KI-Bots nicht zu blockieren.

Lesetipp: Wie ihr eure Produkt-Landingpages optimiert, erfahrt ihr in unserem Beitrag über SEO für Produktseiten.

Fazit

Die robots.txt-Datei ist ein einfaches, aber wichtiges Instrument, um zu steuern, welche Inhalte Crawler erfassen und indexieren dürfen. Beim Blockieren von Bots ist Vorsicht geboten: Falsche Einstellungen können dazu führen, dass eure Inhalte aus Suchergebnissen verschwinden. Wenn ihr eure Inhalte also nicht gesondert schützen wollt, sondern auf Reichweite, Sichtbarkeit und SEO abzielt, solltet ihr die Einstellungen auf Squarespace anpassen und den Block der KI-Bots aufheben.