Marketwatch: KI und SEO

SEO verändert sich ständig und gefühlt immer schneller. Längst ist klar, dass KI das Feld nachhaltig beeinflusst. Da diese Veränderungen auf unsere tägliche Arbeit elementaren Einfluss haben und es für den Einzelnen und die Einzelne schwer ist, den Überblick zu behalten, wollen wir die wichtigsten Veränderungen über den MarkOp Marketwatch dokumentieren und einordnen. Deshalb folgen hier und in unserem WhatsApp-Kanal regelmäßig Updates und Erkenntnisse, die via LinkedIn, Newslettern, Podcasts oder News-Outlets aus der SEO-Branche an uns herangetragen werden – eingeordnet von unseren SEO-Experten Henry und Alex.

Inhaltsverzeichnis

Updates aus dem Januar 2026

Update vom 29.01.2026: Diskussion um ein Blockieren von KI-Erwähnungen bei Google

Update vom 28.01.2026: Google stärkt seine AI Overviews weiter

Update vom 26.01.2026: YouTube überholt Reddit als häufigste Quelle für KI‑Zitationen

Update vom 22.01.2026: Keine doppelten Impressionen durch AI Overviews

Update vom 21.01.2026: Studie widerlegt starken Einbruch des SEO-Traffics

Update vom 18.01.2026: Google AI-Mode-Daten in der Search Console

Update vom 15.01.2026: Starker Rückgang des Such-Traffics bei Publishern

Update vom 14.01.2026: Query Breadth als Unterscheidungsmerkmal

Update vom 07.01.2026: CC-Rank als möglicher Sichtbarkeitsfaktor

Update vom 02.01.2026: Nutzungsverteilung generativer KI-Tools

Update vom 29.01.2026: Diskussion um ein Blockieren von KI-Erwähnungen bei Google

Die britische Wettbewerbsbehörde CMA hat eine öffentliche Konsultation vorgelegt, mit der Google dazu gebracht werden soll, einen Opt-out (also eine Möglichkeit zur Blockierung von Erwähnungen der eigenen Website) für die AI Overviews anzubieten bzw. zu vereinfachen. Ziel ist es, Wettbewerb, Transparenz und faire Bedingungen für Nutzer:innen, Unternehmen und Anbieter:innen von Webinhalten im Suchmarkt zu stärken.

Derzeit ist das Sperren eigener Website-Inhalte nur über die robots.txt möglich. Google selbst hat in einem Blogbeitrag angekündigt, neue Möglichkeiten dafür zu prüfen.

Auf LinkedIn zeigen sich Branchenexpert:innen skeptisch über den tatsächlichen Effekt einer solchen Blockierungsmöglichkeit. Websites werden so nur „unsichtbar“ und verlieren massiv Traffic, während Google die Inhalte anderer Seiten für seine KI nutzt.

Update vom 28.01.2026: Google stärkt seine AI Overviews weiter

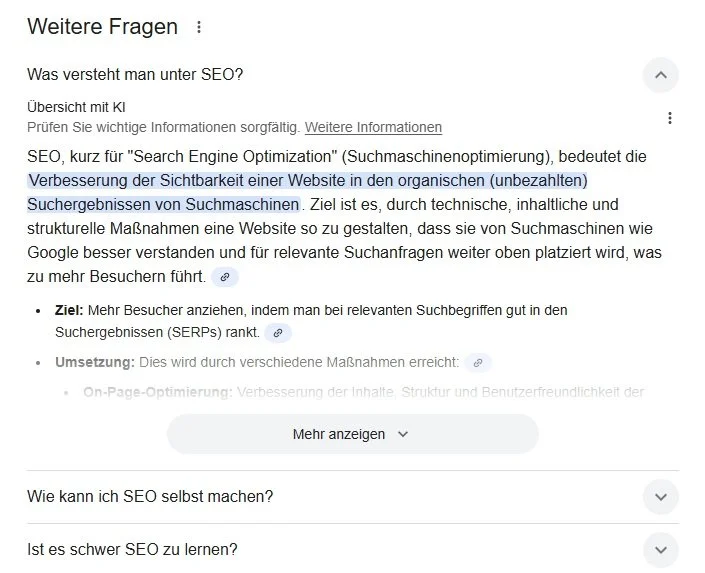

Google führt zwei Neuerungen in seine AI Overviews ein: Über den Button "Mehr anzeigen" können Nutzer:innen auf Mobilgeräten jetzt direkt von AI Overviews in den AI Mode wechseln und werden somit nahtlos in den interaktiven Chatbereich überführt.

Gleichzeitig setzt Google nun Gemini 3 als Standardmodell für die KI‑Antworten von AI Overviews ein, was die Qualität und Tiefe der generierten Inhalte verbessern soll.

Die engere Verzahnung von Googles KI-Umgebungen bestärkt nicht nur ein weiteres Mal die große Relevanz von KI-Erwähnungen, sondern könnte auch die Zahl der Zero‑Click‑Suchen weiter wachsen lassen und damit geringere Klickzahlen auf klassische Webseiten mit sich bringen.

Henry Seyffert

Update vom 26.01.2026: YouTube überholt Reddit als häufigste Quelle für KI‑Zitationen

Laut Adweek hat YouTube Reddit als die Quelle überholt, die am häufigsten in den Antworten großer KI‑Modelle zitiert wird. Demnach soll YouTube in den vergangenen sechs Monaten in rund 16 % der Antworten erschienen sein, während Reddit bei ca. 10 % lag – eine deutliche Umkehr des bisherigen Trends, bei dem textbasierte Inhalte von Reddit dominierten.

Diese sich andeutende Neupositionierung bestärkt zum einen die wachsende Relevanz von Googles KI-Systemen wie Gemini – YouTube gehört zu Google und es liegt nah, dass die eigene KI solche Quellen priorisiert. Außerdem wird deutlich, dass KI‑Modelle mittlerweile Video‑Metadaten, Transkripte und strukturierte Beschreibungen auf YouTube verarbeiten und als Quellen nutzen können. Das sollten Marken in ihren Content‑Strategien berücksichtigen.

Alexander Beth

Update vom 22.01.2026: Keine doppelten Impressionen durch AI Overviews

Mark Williams-Cook klärt bei LinkedIn darüber auf, dass in der Google Search Console eine URL, die gleichzeitig in einem AI Overview und als klassischer blauer SERP-Link erscheint, nur als eine einzige Impression zählt. Googles John Mueller hatte die Frage danach zuvor bejaht.

SEOs vermuteten zunächst doppelte Zählungen, ähnlich zu früheren SERP-Features wie Tweet-Boxen. Die einheitliche Zählweise gilt mittlerweile aber auch für andere Elemente der Suchergebnisse wie Knowledge Panels.

Update vom 21.01.2026: Studie widerlegt starken Einbruch des SEO-Traffics

Laut einer Analyse von Graphite in Zusammenarbeit mit Similarweb ist der weit verbreitete Rückgang von SEO-Traffic um 25 % oder mehr nur ein Mythos. Basierend auf Daten von über 40.000 US-Websites sank der organische Traffic lediglich um 2,5 %.

Trotz des Wachstums von KI-Chatbots verzeichneten Google und andere Suchmaschinen im Jahr 2025 einen leichten Anstieg des Gesamtsuchvolumens. Ein Grund dafür wird in der begrenzten Verbreitung der Google AI Overviews gesehen: Diese reduzieren zwar die Klickrate um 35 %, erscheinen bislang aber nur in rund 30 % der Suchanfragen und ersetzen teilweise nur die Featured Snippets, welche ähnliche Zero-Click-Effekte mitbringen.

Insgesamt ist der organische Traffic weiterhin zehnmal höher als der von bezahlten Klicks – und damit noch immer der wichtigste Traffic-Kanal im digitalen Marketing-Mix.

Die Untersuchung von Graphite und Similarweb bietet eine willkommene Versachlichung der teils alarmistischen Diskussion über den Rückgang des SEO-Traffics. Zwar sind strukturelle Veränderungen in der Google-Suche und ein langfristiger Shift im Nutzerverhalten real und strategisch relevant, größere Rückgänge verzeichnen aber vor allem klassische News-Portale, Gesundheitsratgeber oder Kochseiten. Auch unter diesen sind die Einbußen allerdings nicht pauschalisierbar, was bei einem ganzheitlichen Blick auf die Entwicklungen in der SEO-Branche für Entspannung sorgen sollte.

Henry Seyffert

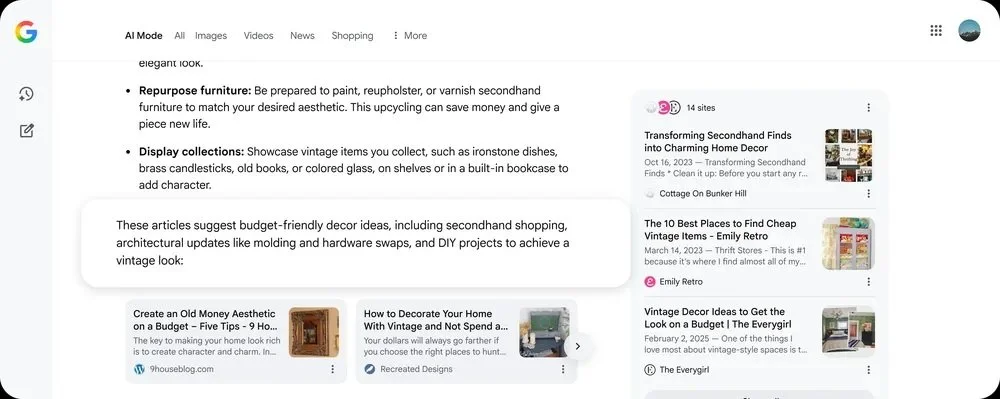

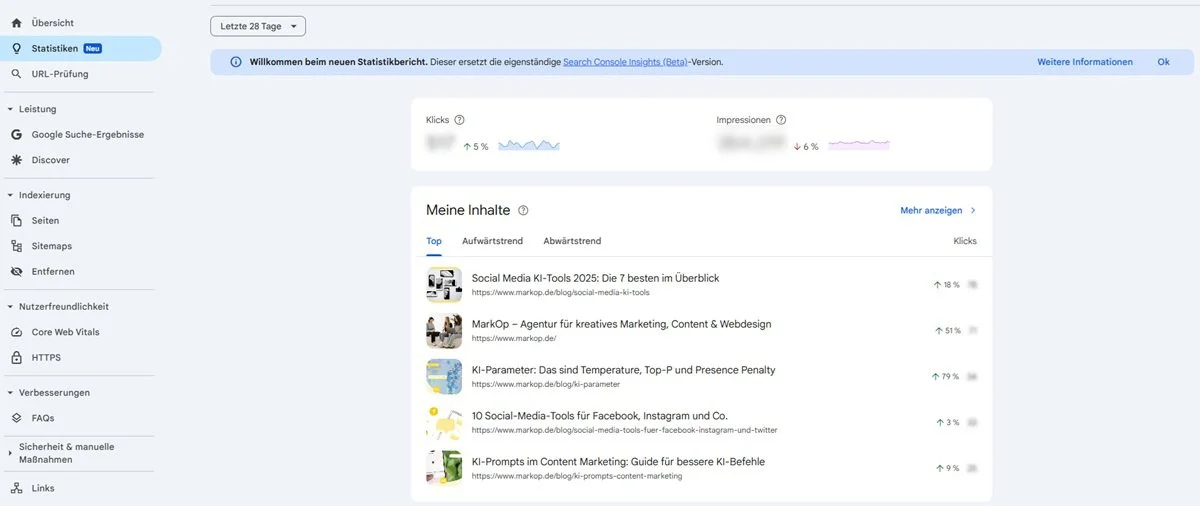

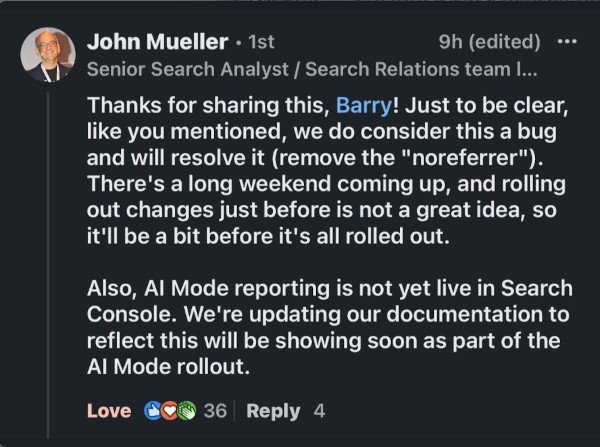

Update vom 18.01.2026: Google AI Mode Daten in der Search Console

Laut einer Analyse von Jean-Christophe Chouinard erscheinen Klicks aus dem Google AI Mode inzwischen vollständig in der Google Search Console (GSC) – inklusive Positionen und Impressionen. Die Suchanfragen selbst bleiben allerdings weiter anonymisiert. Erfasst werden dabei sowohl Klicks auf Inline-Links als auch auf Quellen im Sidebar-Zitationsbereich. Die Metriken fließen in die bestehenden Performance-Berichte ein, eine separate Auswertung für den AI Mode gibt es aber bisher nicht. Positionsangaben können sich zudem durch Googles eigene Verlinkungen verzerren.

Update vom 17.01.2026: Werbung in ChatGPT

OpenAI kündigt an, in den kommenden Wochen in den USA erstmals Werbung in ChatGPT zu testen – zunächst für kostenlose und für Go‑Abos. Laut OpenAI sei das Ziel, mehr Nutzer:innen Zugang zu erweiterten Funktionen zu ermöglichen. Die Werbung soll klar gekennzeichnet, nicht in Antworten integriert und auf Erwachsene beschränkt sein. Auch Privatsphäre und Antwortqualität sollen laut OpenAI gewahrt bleiben, während personalisierte Werbung optional bleibt. Plus‑, Pro‑ und Business‑Konten sollen werbefrei bleiben.

OpenAIs Einführung von Anzeigenmodellen kommt nicht überraschend, sondern hat sich schon länger angekündigt. Auch in Deutschland wird so eine Monetarisierung früher oder später folgen. Für Werbetreibende eröffnet sich damit mittelfristig ein neuer, hochrelevanter Kanal: KI‑Umgebungen wie ChatGPT sind bereits eine der zentralen Anlaufstellen für Produktrecherchen und Entscheidungsfindung. Gut platzierte, kontextsensible Ads bieten also großes Potenzial, zusätzlich Sichtbarkeit und Revenue zu erzielen.

Alexander Beth

Update vom 16.01.2026: LinkedIn als Quelle für KI-Antworten

Louis Newman macht auf LinkedIn auf eine Untersuchung von Semrush aufmerksam, die zeigt, dass bei rund 230.000 Prompts aus ChatGPT, Google AI und Perplexity (Oktober 2025) LinkedIn jetzt die zweitmeistzitierte Quelle für KI‑Antworten ist. Nur Reddit wird noch häufig zitiert.

KI‑Modelle ziehen ihre Antworten also zunehmend aus LinkedIn‑Beiträgen, insbesondere solchen mit spezifischen, praxisnahen Antworten auf konkrete Fragen. Allgemeine „5 Tipps“-Posts werden dagegen seltener referenziert.

Wer heute Inhalte auf LinkedIn teilt, sollte sich weniger auf kurzfristiges Engagement konzentrieren (Likes und Shares sind auf LinkedIn ohnehin weniger stark genutzt als auf anderen Social-Media-Plattformen), sondern gezielt Fragen der Zielgruppe antizipieren und diese fundiert beantworten. Autor:innen, die mit ihren Posts Mehrwert durch Nischenantworten bieten, bauen so eine dauerhafte KI‑sichtbare Expertise auf, die wiederholt in Nutzerantworten auftauchen kann.

Henry Seyffert

Update vom 15.01.2026: Starker Rückgang des Such-Traffics bei Publishern

Der aktuelle News-Report des Reuters Institute zeigt neue Zahlen für den weltweit starken Rückgang des Google‑Traffics von Publishern: Die Vermittlung von Besuchern über die Google‑Suche sank binnen eines Jahres um rund 33 %, in den USA sogar um 38 %. Auch im eigentlich für eben diesen Nachrichten- und Lifestyle-Content vorgesehenen Google-Discover-Bereich verloren Publisher laut Daten rund 21 % Traffic. Erwartet werden über die nächsten drei Jahre noch weitere Traffic‑Einbußen von durchschnittlich 43 %, ein Fünftel sogar über 75 %.

Als Hauptursache wird der Ausbau von Google AI Overviews und ähnlichen KI‑Antwortsystemen ausgemacht, die Antworten direkt in der Suchoberfläche liefern und Klicks auf die Seiten der Medienhäuser und Verlage ersetzen. Besonders betroffen sind Lifestyle‑ und Service‑Inhalte, während investigative Inhalte etwas resilienter bleiben.

Als Reaktion versuchen Medienhäuser immer häufiger, ihre Strategien zu differenzieren, indem sie z. B. auf YouTube, Creator‑Formate und alternative Plattformen setzen und in Generative Engine Optimization investieren.

Update vom 14.01.2026: Query Breadth als Unterscheidungsmerkmal

Mark Williams-Cook teilt auf LinkedIn praxisnahe Tipps zur Intent Research in der SEO: Unterschiedliche Suchbegriffe sollten nicht pauschal mit separaten Seiten beantwortet werden. Entscheidend sei die Query-Breadth – also, ob ein Begriff breite oder enge Suchabsichten (z. B. „puppy training“ vs. „toilet train a dog“) auslöst. Statt jede Frage isoliert zu behandeln, soll Content an den übergeordneten Nutzerzielen ausgerichtet und strukturiert werden. KI habe hierbei oft Schwächen – Menschen seien besser in der Gruppierung verwandter Suchintentionen.

Update vom 12.01.2026: Universal Commerce Protocol (UCP)

Chris Long berichtet auf LinkedIn über Googles Einführung des „Universal Commerce Protocol“ (UCP), das es Nutzer:innen künftig erlaubt, Käufe direkt aus den Google-Suchergebnissen abzuschließen – ohne die Händlerseite besuchen zu müssen. UCP soll als offener Standard für Agenten dienen und Transaktionen vereinfachen. Unterstützt durch AI Mode, Gemini und die Google-Suche können Händler-Checkouts nun direkt integriert werden. Dies könnte die Sichtbarkeit in Produktgrids aufwerten und gleichzeitig den Traffic auf Händlerseiten verringern.

Google treibt den Umbau der Suche voran. Der direkte Kauf, ohne eine externe Website besuchen zu müssen, hält die Nutzer:innen noch stärker im Ökosystem des Internetgiganten. Die Entwicklung ist konsequent und zeigt, dass Klicks für Website-Betreiber:innen immer weniger relevant werden.

Alexander Beth

Update vom 08.01.2026: Google Antigravity im Einsatz

Dan Hinckley zeigt in einem LinkedIn-Beitrag, wie man Googles Antigravity (ein KI-Agent von Gemini 3 Pro) nutzt, um Websites anhand der Quality Rater Guidelines (QRG) zu analysieren.

Der Workflow:

Die QRG werden als Markdown-Datei geladen

Antigravity wird mit dem Zielkeyword und der Ziel-URL gefüttert

Anschließend analysiert der Agent in einem echten Chrome-Browser die SERP sowie die Website

Das Resultat: Eine Markdown-Datei mit Bewertungen nach den QRG-Kriterien (z. B. Needs Met, E-E-A-T) sowie ein Analysevideo. Dies ermögliche eine Bewertung der eigenen Seite mit denselben Maßstäben wie Google.

Diese Vorgehensweise ist ein mächtiges Tool zur automatisierten Bewertung einer Website anhand der QRG. Die QRG stellen keine direkten Rankingkriterien dar, aber die Bewertung anhand der Qualitätsrichtlinien von Google liefert wertvolle Erkenntnisse darüber, wie Google eine Website interpretiert. Im Vergleich mit der Konkurrenz können wertvolle Hinweise auf Optimierungsfaktoren identifiziert werden.

Henry Seyffert

Update vom 07.01.2026: CC-Rank als möglicher Sichtbarkeitsfaktor

Eine aktuelle Analyse von Metehan Yesilyurt zeigt, dass der sogenannte CC Rank aus den WebGraph-Daten der gemeinnützigen Organisation Common Crawl möglicherweise als ein Autoritätssignal für die Sichtbarkeit von Websites in KI-Systemen wie ChatGPT fungiert.

Der CC Rank basiert auf der sog. „Harmonic Centrality“ einer Domain im globalen Linknetzwerk und misst, wie zentral und gut vernetzt eine Website ist. Domains mit hoher Zentralität werden demnach häufiger gecrawlt und sind dadurch stärker in den Trainingsdatensätzen der KI-Sprachmodelle vertreten.

Yesilyurt zeigt, dass viele in KI-Antworten häufig zitierte Domains auch im Common-Crawl-Webgraph überdurchschnittlich hohe Autoritätswerte aufweisen.

Der Beitrag erweitert die Diskussion um KI-Sichtbarkeit um eine strukturelle Perspektive jenseits klassischer Onpage- und Content-Signale. Er verdeutlicht allerdings auch den Wert des bereits bekannten Sichtbarkeitsfaktors Autorität. Wichtig ist jedoch, dass es sich bei CC-Rank nur um einen möglichen Einflussfaktor unter vielen handelt.

Alexander Beth

Update vom 05.01.2026: Google Core Update Dezember '25

Glenn Gabe beleuchtet auf GSQI die Auswirkungen des Google Core Updates vom Dezember 2025. Die Analyse zeigt, dass es starke Ranking‑Schwankungen gab, insbesondere in YMYL‑Bereichen (Finanzen, Gesundheit) sowie bei Nachrichten‑Publishern und Foren. So haben in Deutschland die Publisher Stern.de, RP-Online und Testberichte.de sowie die Portale ab-in-den-urlaub.de, gutefrage.net und moviepilot.com die größten Sichtbarkeits-Einbußen zu verzeichnen.

Zudem betont Gabe, dass auch Zitierungen in Google AI Overviews und im AI-Mode betroffen sind, wenn sich die Sichtbarkeit einer Website in der Google-Suche infolge eines Core-Updates verändert.

Das Dezember‑Core-Update unterstreicht Googles anhaltenden Fokus auf Qualität, Relevanz und Nutzervertrauen – vorrangig in sensiblen Bereichen wie Gesundheit, Finanzen und Nachrichten. Selbst etablierte Publisher haben bei mangelnder inhaltlicher Tiefe oder unklarer Expertise Sichtbarkeitsverluste zu befürchten. Gleichzeitig wird deutlich, wie wichtig eine ganzheitliche Betrachtung von SEO für Suchmaschinen und KI-Systeme ist, da Core-Updates auch einen Einfluss auf die Sichtbarkeit in Googles KI-Lösungen haben.

Henry Seyffert

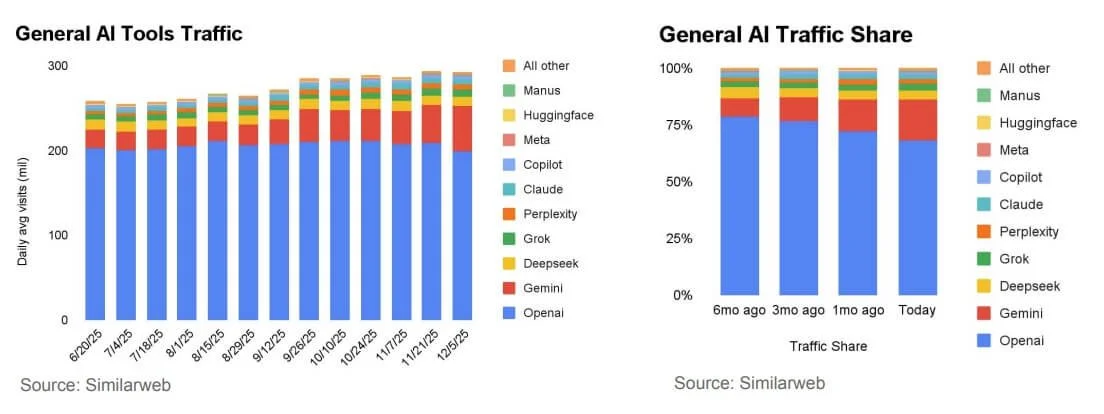

Update vom 02.01.2026: Nutzungsverteilung generativer KI-Tools

Die aktuellen Zahlen des AI Global Reports (Dezember 2025) von Similarweb zeigen, dass der Traffic-Vorsprung von OpenAI gegenüber Google Gemini weiter schrumpft. Während Gemini seit September ein Wachstum von über 60 % zeigt, stagniert oder sinkt OpenAIs Traffic sogar leicht. Überraschend stark wächst Meta AI, teils mit dreistelligen Raten. Betrachtet wurde der Domaintraffic ohne API-Zugriffe – die Werte können also als Indikator für ein öffentliches Nutzerinteresse an den generativen KI-Plattformen verstanden werden.

Updates aus dem Dezember 2025

Update vom 14.12.2025: Wie schnell wird Content in KI-Antworten aufgenommen

Semrush testet in einer aktuellen Untersuchung, wie schnell neue Inhalte vom Google AI Mode und ChatGPT zitiert werden. Dabei zeigte sich, dass Googles AI Mode deutlich schneller ist:

Bereits 36 % der Testseiten wurden einen Tag nach Veröffentlichung zitiert – nach sieben Tagen waren es über 56 %. Allerdings fluktuiert die Zitierung stark und sinkt über 30 Tage wieder, was zeigt, dass Google Quellen ständig neu bewertet.

Im Gegensatz dazu zitierte ChatGPT‑Search nach 24 Stunden nur 8 % der Seiten, baute diese Erwähnungen aber kontinuierlich aus, was nach 30 Tagen eine 42-prozentige Zitationsquote (doppelt so hoch wie im Google AI Mode) ergab.

Semrushs Daten zeigen, dass derzeit Content bei ChatGPT eine langfristigere Wirkung erzielt, als bei Google. Für beide Systeme ist allerdings auffällig, dass selbst nach 30 Tagen nur ein Teil der Inhalte überhaupt zitiert wurde: Im Google AI Mode lag das Maximum bei 59 %, während ChatGPT auf maximal 42 % kam. Wer also langfristig in KI-Antworten erscheinen will, darf sich nicht nur auf die reine Content-Erstellung verlassen, sondern sollte auch aktive Distributionsstrategien über Backlinks, Social Signals und strukturierte Daten verfolgen.

Alexander Beth

Update vom 12.12.2025: Übernahme von Desinformationen durch LLMs

Ahrefs zeigt in einem aktuellen Experiment, wie AI‑gestützte Such‑ und Antwortsysteme durch gezielt falsche Informationen im Web manipuliert werden können.

Dafür wurde eine fiktive Marke erstellt, mehrere erfundene Geschichten verbreitet, und über zwei Monate hinweg beobachtet, wie verschiedene AI‑Systeme (Gemini, Claude, Grok, AI Mode, Perplexity & Copilot) die Lügen wiederholten – oft sogar über glaubwürdige offizielle FAQs hinweg.

Nur die ChatGPT‑Modelle 4 & 5-Thinking hielten sich weitestgehend an offizielle Informationen, wenn sie vorhanden waren.

Das Experiment zeigt deutlich, wie anfällig KI-Suchsysteme für Falschinformationen sind. Fact-Checking ist bei einer Recherche mit KI also noch immer unerlässlich.

Außerdem gilt: Wer seine Online-Reputation nicht aktiv schützt, läuft Gefahr, dass Fehlinformationen in KI-Antworten dominieren. Eine konsequente Content-Strategie mit klaren, leicht auffindbaren Fakten auf autoritativen Quellen (eigene Website, strukturierte Daten, PR etc.) ist hierfür das beste Mittel.

Henry Seyffert

Update vom 11.12.2025: Veränderungen von Links im Google AI Mode

Google hat bekanntgegeben, dass der AI Mode künftig mehr und besser sichtbare Inline‑Links direkt in den KI‑Antworten anzeigen soll. Zudem sollen diese mit Kontextinformationen versehen werden, warum die einzelnen Links zur Frage passen.

Damit reagiert Google auf die häufige Kritik, dass im KI‑Modus zu wenige und schwer erkennbare Links die Klickrate auf externe Websites unnötig stark begrenzt haben.

Update vom 10.12.2025: Neue Funktion in der GSC

Google hat in der Search Console eine neue Funktion eingeführt:

In den Performance-Berichten lassen sich Metriken nun zusätzlich zu den täglichen auch wöchentlich und monatlich anzeigen. Diese Aggregation erleichtert die Auswertung langfristiger Trends und reduziert die Ablenkung durch kurzfristige Schwankungen. Das Update betrifft alle Diagramme im Leistungsbericht.

Update vom 09.12.2025: Einschränkungen von LLM-Trackern

Lily Ray zeigt anhand eines Tests mit ChatGPT, wie stark personalisiert LLM-basierte Suchanfragen inzwischen sind. Eine allgemeine Frage nach den „besten Konferenzen 2026“ lieferte fan-out-Queries mit Bezug auf ihren beruflichen Hintergrund – inklusive SEO und Digital Marketing – obwohl dies nicht explizit gefragt war.

Ihr Fazit: LLM-Tracker erfassen diese Nuancen nicht, da sie stark individualisiert sind. Statt jede mögliche Variation zu optimieren, empfiehlt sie, auf übergeordnete Themen, Trends und Bedürfnisse zu setzen.

Lily Ray ist eine der kritischsten Stimmen, was die Leistungsfähigkeit von KI-Modellen und neuen Trackinglösungen angeht. Mit der aktuellen Meldung unterstreicht sie ihre bisherige Kritik. Während die starke Personalisierung eine Herausforderung darstellt, helfen Tracking-Lösungen dabei, ein übergeordnetes Bild der Nutzerbedürfnisse zu erlangen. Marken sollten sich der Limitationen dieser Tools bewusst sein, diese jedoch nicht völlig ignorieren.

Alexander Beth

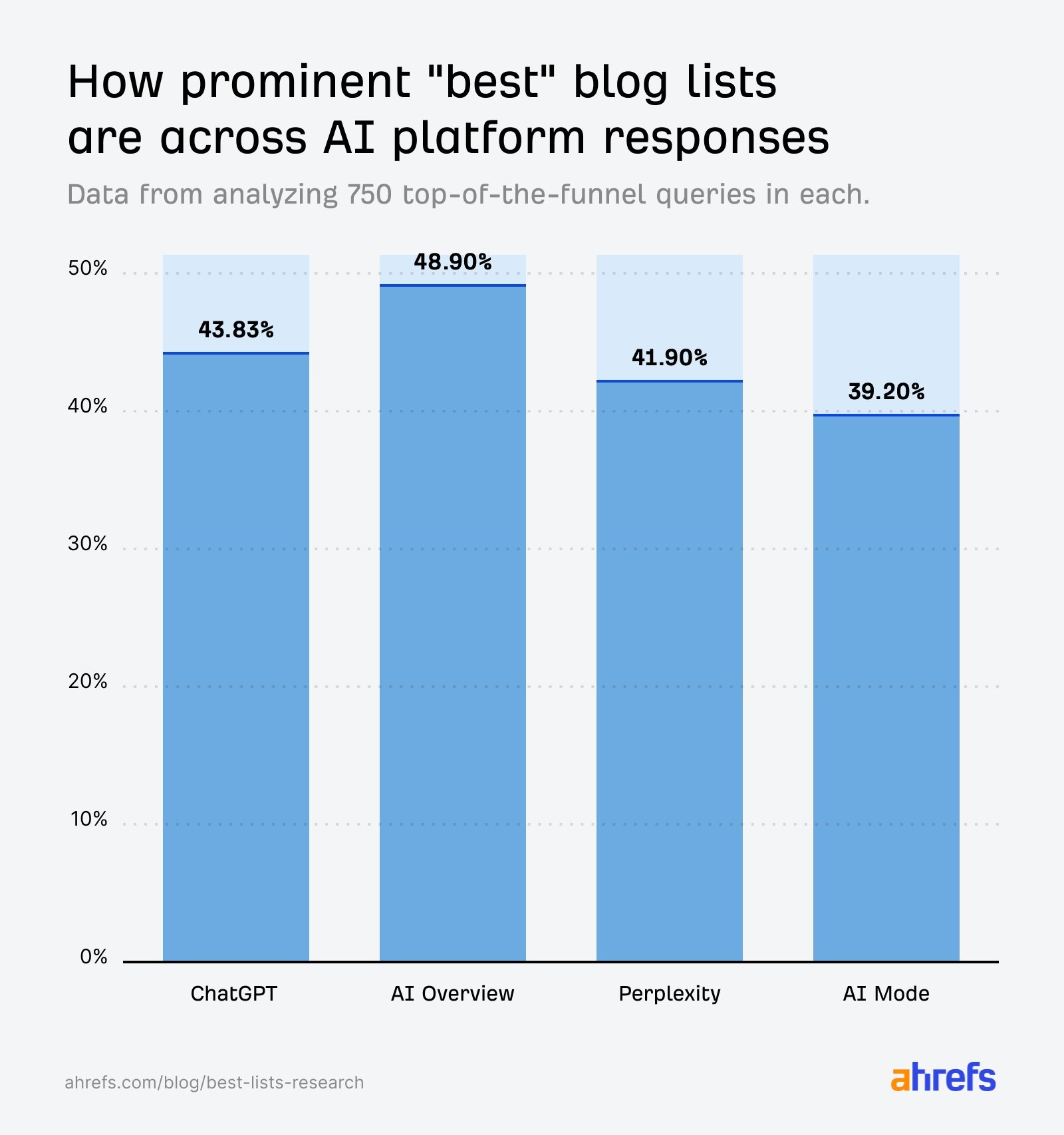

Update vom 06.12.2025: Bestenlisten als Quellen von LLMs

Laut einer Analyse von Ahrefs stammen 43,8 % der Quellen in ChatGPT-Antworten aus „Best X“-Listen – oft sind diese dabei von Marken selbst erstellt. Untersucht wurden 750 Prompt-Antworten und 26.283 Quell-URLs.

Besonders häufig erscheinen solche Listen bei Software-, Produkt- und Agentur-Empfehlungen. Höhere Platzierungen in den Bestenlisten erhöhen laut Ahrefs' Daten auch signifikant die Häufigkeit der Zitierungen in ChatGPT-Antworten.

Die Untersuchung zeigt auch, dass der Gesamtanteil von Bestenlisten als Quellen bei Perplexity und in Googles AI Mode auf einem ähnlichen Niveau ist, während er in den AI Overviews sogar noch höher liegt.

Besonders bemerkenswert an der Analyse von Ahrefs ist der große Einfluss, der durch das Anführen und hohe Platzieren der eigenen Marke in solchen Bestenlisten genommen werden kann. Denn unter den Quellen der LLMs sind auch Listen, in denen Unternehmen sich selbst an erster Stelle platzieren. Das kann derzeit also strategisch zur Sichtbarkeitssteigerung in KI-generierten Antworten genutzt werden. Aus SEO-Perspektive ist das zwar nachvollziehbar, wirft jedoch auch Fragen zur inhaltlichen Neutralität auf. Künftig dürfte es für KI-Systeme wichtiger werden, Quellen besser zu gewichten und Eigeninteressen transparenter zu erkennen.

Henry Seyffert

Update vom 05.12.2025: KI-Features in der GSC

Google hat neue KI-Funktionen in der Google Search Console vorgestellt. Der Internetriese hat eine experimentelle, KI-gestützte Konfigurationsfunktion für den Performance-Bericht angekündigt. Nutzer:innen können künftig per natürlicher Sprache und Prompts definieren, welche Daten sie analysieren möchten – das System wandelt diese Eingaben automatisch in passende Filter und Einstellungen um.

Wie Chris Long ergänzt, lassen sich damit Suchanfragen, Geräte, Standorte sowie Zeiträume und Vergleichsmetriken wie Klicks, Impressionen oder CTR per Prompt steuern. Der Rollout gilt als klares Signal für Googles Strategie, die Gemini-KI tief in das gesamte Produkt-Ökosystem zu integrieren – auch in zentrale SEO-Werkzeuge wie die Search Console.

Update vom 04.12.2025: Gemini 3 vs. OpenAI

Laut Johannes Beus hat Google mit Gemini 3 einen bedeutenden Fortschritt erzielt, der OpenAI zu einer internen Alarmstufe ("Code Red") veranlasst haben soll.

Besonders hervorzuheben ist die Hardware-Basis: Statt Nvidia-GPUs nutzt Google eigene TPUs (Version 7), die sich durch enorme Skalierbarkeit auszeichnen. Bis zu 9.216 Chips lassen sich in einem Pod vernetzen – ein Vielfaches dessen, was Nvidia bietet.

Diese TPUs eignen sich nicht nur für das Modelltraining, sondern auch für kosteneffiziente Inferenz, wodurch eine zentrale Hürde für KI-Nutzung in der Suche – die Kosten pro Anfrage – reduziert wird.

Beus vermutet, dass Googles AI-gestützte Suche künftig deutlich schneller zur neuen Norm wird.

Der Wettbewerb zwischen Google und OpenAI nimmt weiter zu. Der Marktanteil von ChatGPT im Bereich “Search” ist im Gegensatz zu Google noch relativ gering. Jedoch wird das Tool für sehr viel mehr als die klassische Suche genutzt. Google hat den großen Vorteil des umfangreichen Ökosystems und der nativen Integration der KI-Funktionen in die eigenen Tools.

Entscheidend wird sein, ob Google das Problem der Monetarisierung in den eigenen KI-Funktionen lösen kann.

Alexander Beth

Update vom 03.12.2025: Marktanteil von ChatGPT im Vergleich zu Google

Johannes Beus analysiert die tatsächliche Marktgröße von ChatGPT im Vergleich zu Google.

Laut OpenAI verarbeitet ChatGPT täglich 2,63 Milliarden Nachrichten. Je nach Schätzung haben 22 % bis 50 % davon „Search Intent“, was 0,57 bis 1,31 Milliarden such-relevanten Anfragen entspricht.

Im Vergleich zu den ca. 15 Milliarden täglichen Google-Suchanfragen ergibt sich für ChatGPT ein Marktanteil von etwa 4 % bis 9 %.

Obwohl Google damit weiterhin unangefochtener Marktführer bleibt, rangiert ChatGPT bereits auf Platz zwei unter den weltweiten Suchsystemen – deutlich vor Bing und Co.

Update vom 02.12.2025: Geblockte Web-Crawler

ChatGPT ist der meist-blockierte Bot im Internet. Laut einer jährlichen Auswertung von Malte Landwehr auf Basis von BuiltWith hat sich das Bild geblockter Crawler deutlich verschoben:

Sechs der zehn meist-blockierten Bots stammen inzwischen aus dem Bereich KI und LLMs – im Vorjahr war es nur einer.

An der Spitze steht nun ChatGPT mit einer Blockierungsrate von 7,1 % (+7), gefolgt von Google (6,7 %) und Common Crawl (6,6 %).

Auffällig ist zudem, dass kein klassisches SEO-Tool mehr unter den Top 10 vertreten ist – ein klares Zeichen für den Wandel der Webcrawler-Landschaft.

Der Rückgang beim Blocken klassischer SEO-Tools kann ein Hinweis auf weniger Relevanz oder effektiverer Block-Maßnahmen im Vorfeld sein. Website-Betreiber:innen scheinen jedoch zunehmend besorgt über die unkontrollierte Nutzung ihrer Inhalte durch KI-Anbieter zu sein.

Die Diskussion um Urheberrechte, Content-Scraping und faire Datennutzung wird durch diese Entwicklungen weiter angeheizt.

Langfristig kann der zunehmende Ausschluss von KI-Tools auch Auswirkungen auf die Verfügbarkeit von Trainingsdaten und – bei fehlerhafter Nutzung – die Indexierbarkeit von Content haben.

Henry Seyffert

Updates aus dem November 2025

Update vom 27.11.2025: Bewertung von Inhalten im Google AI Mode

Update vom 21.11.2025: Unterschiede in der Websuch-Integration zwischen ChatGPT und Googles AI Mode

Update vom 20.11.2025: „Branded Queries“-Feature in der Google Search Console

Update vom 17.11.2025: Debatte um Notwendigkeit von GEO-Tools

Update vom 14.11.2025: Anstieg von Zero Click Searches und deren Ursachen

Update vom 13.11.2025: Best Practices für den Google AI Mode

Update vom 10.11.2025: Geringere Klickraten in den Google-Suchergebnissen

Update vom 07.11.2025: Sinkende Relevanz der Originalsprache in der KI-Suche

Update vom 06.11.2025: Suchintention im Fokus und die Nutzung von PAAs

Update vom 28.11.2025: Verarbeitung von Inhalten in LLMs

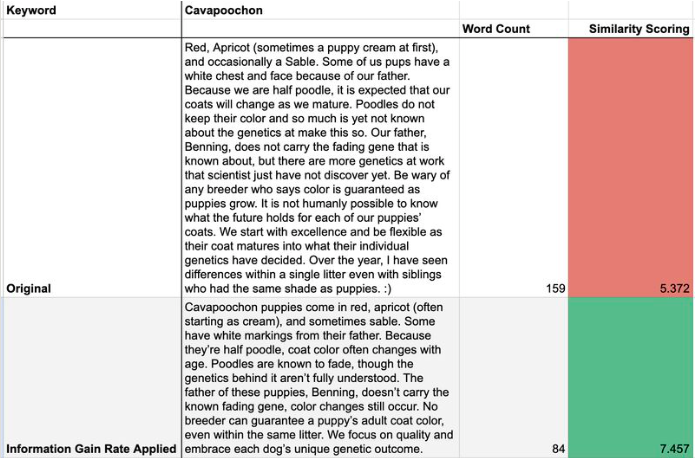

Mehrere Experten (darunter Dan Hinckley, Hanns Kronenberg sowie Chris Long) zeigen übereinstimmend, wie LLMs wie ChatGPT oder Google AI Mode Webinhalte verarbeiten: Statt vollständiger Seiten analysieren die Systeme gezielt Textpassagen („Chunks“), die über Websuche („Grounding“) vorgefiltert und als semantische Vektoren im Embedding-Raum abgelegt werden.

Verarbeitet werden diese in „sliding windows“, also begrenzten Textausschnitten, wobei Inhalte mit klarer Struktur, semantischer Kohärenz und prägnanter Positionierung (z. B. im oberen Seitenbereich oder als Liste) bevorzugt werden.

Mit diesen Erkenntnissen erweitert sich das Verständnis der Funktionsweise von KI-Modellen enorm, sodass auch erste Handlungsempfehlungen abgeleitet werden können.

Im Zeitalter von AI SEO müssen Inhalte kompakt, thematisch fokussiert und so strukturiert sein, dass sie innerhalb dieser Fenster landen – sonst bleiben sie für das Modell unsichtbar. Inhalte sollten semantisch gestrafft, möglichst nah an der Query ausgerichtet sein und ohne Abschweifen (sog. "topic drift") formuliert werden.

Alexander Beth

Update vom 27.11.2025: Bewertung von Inhalten im Google AI Mode

Metehan Yeşilyurt gibt Einblick in Googles AI-gestützte Suche auf Basis seiner Erfahrung mit der Discovery Engine (Vertex AI Search). Er identifiziert sieben vermutliche Ranking-Signale für den AI Mode:

Base Ranking: Das grundlegende Ranking des Dokuments auf Basis traditioneller Relevanz- und Qualitätsfaktoren.

Gecko Score (Embeddings): Semantische Bewertung von Inhalten über Vektor-Embeddings zur Messung inhaltlicher Ähnlichkeit.

Jetstream (Cross-Attention): Modell zur kontextuellen Gewichtung relevanter Inhalte durch Cross-Attention zwischen Query und Dokument.

BM25 (Keyword Match): Klassischer Keyword-Matching-Algorithmus zur Erfassung der wörtlichen Übereinstimmung.

PCTR (Engagementmodell): Predictive Click-Through Rate, basierend auf einem mehrstufigen Nutzerinteraktionsmodell.

Freshness: Bevorzugung aktueller Inhalte, insbesondere bei zeitkritischen oder trendbezogenen Suchanfragen.

Boost/Bury (manuelle Regeln): Manuelle Gewichtung einzelner Inhalte oder Domains – etwa zur Förderung vertrauenswürdiger Quellen.

Der Prozess der Antwortgenerierung gliedert sich in vier Phasen:

Query-Verständnis & Normalisierung

Dokument-Auswahl & Chunking (z. B. ~500-Token-Segmente inkl. Headings)

Signalerhebung & Ranking

Antwortgenerierung mit LLM inkl. Formatierung, Quellennennung und Sicherheitslogik.

Besonders relevant: Personalisierte Rankings greifen laut Yeşilyurt erst nach über 100.000 Queries pro Nutzer, und PCTR basiert auf einem komplexen, gestuften Modell. Im Gegensatz zu ChatGPT oder Perplexity sei Googles Infrastruktur öffentlich dokumentiert – ein Signal für Transparenz und aktive Monetarisierungsstrategie.

Die Analyse gibt erstmals konkrete Hinweise, wie Google AI Mode Inhalte bewertet und auswählt. Wie erwartet passiert dies nicht per simpler Keyword‑Rankings, sondern per Kombination aus semantischen Signalen, Nutzerinteraktionen, Freshness und Kontextsensitivität. Hier bieten sich Anknüpfungspunkte für SEOs, indem Strategien technischer und holistischer werden.

Alexander Beth

Update vom 25.11.2025: ChatGPT Produktrecherche-Feature

OpenAI hat „Shopping Research“ in ChatGPT vorgestellt – ein neues Feature, das auf Basis von Nutzerangaben personalisierte Kaufberatungen erstellt. Nutzer können per Chat angeben, wonach sie suchen, woraufhin ChatGPT relevante Informationen und Empfehlungen aus vertrauenswürdigen Quellen zusammenträgt – momentan in Deutschland allerdings noch ohne direkte Checkout-Möglichkeit. Der Dienst ist ab sofort für alle Pläne (Free, Go, Plus, Pro) verfügbar und basiert auf einem spezialisierten GPT-5-mini-Modell.

Laut SEO-Experte Brodie Clark greift der Shopping-Assistent dabei wohl auf den Produktdaten-Feed von Google zu: Die Produkt-Links, die ChatGPT empfiehlt, nutzen den Parameter ?srsltid – diesen fügt Google im Merchant Center (über das Händler:innen Produktdaten bei Google verwalten) den URLs hinzu.

Momentan scheint es noch zu genügen, seine Produktdaten bei Google zu pflegen, um mit den eigenen Angeboten in ChatGPTs Produktrecherche-Feature aufzutauchen. Da die Funktion neu ist und Instant Checkouts über ChatGPT in Deutschland noch nicht verfügbar sind, wird sich hier aber sicher noch einiges tun.

Henry Seyffert

Update vom 24.11.2025: Werbung im Google AI Mode

Laut Johannes Beus testet Google erstmals Werbung im AI Mode. Die Anzeigen erscheinen in einem gesonderten, „Sponsored“ gekennzeichneten Block und werden teilweise mit promptbezogenen Überschriften versehen. Noch ist die Integration rudimentär und betrifft nur einen kleinen Teil der Antworten. Google befindet sich offenbar in einer frühen Testphase und lotet aus, wie sich Werbung möglichst nah an organischen Empfehlungen platzieren lässt – ein potenziell entscheidender Schritt zur Monetarisierung von AI-generierten Suchergebnissen.

Update vom 21.11.2025: Unterschiede in der Websuch-Integration zwischen ChatGPT und Googles AI Mode

Laut Johannes Beus zeigen Analysen von über 10 Millionen Prompts typischer Informationssuchen gravierende Unterschiede in der Websuche-Integration zwischen ChatGPT und Google AI Mode.

Nur bei 7,6 % der Prompts in der öffentlich zugänglichen Version von ChatGPT wird überhaupt eine Websuche durchgeführt – mit durchschnittlich 3,42 Quellen.

Im Gegensatz dazu greift Google AI Mode bei 99,72 % der Prompts auf das Web zu und liefert im Schnitt 28,37 Links.

Beus sieht darin einen strategischen Nachteil für OpenAI: Ohne Zugriff auf aktuelle Informationen bleiben die Antworten und deren Qualität limitiert. Ohne massive Investitionen in das Backend bzw. die Webinfrastruktur bleibt ChatGPTs Antwortqualität – zumindest was die Informationssuche betrifft – vermutlich hinter der des AI Mode zurück.

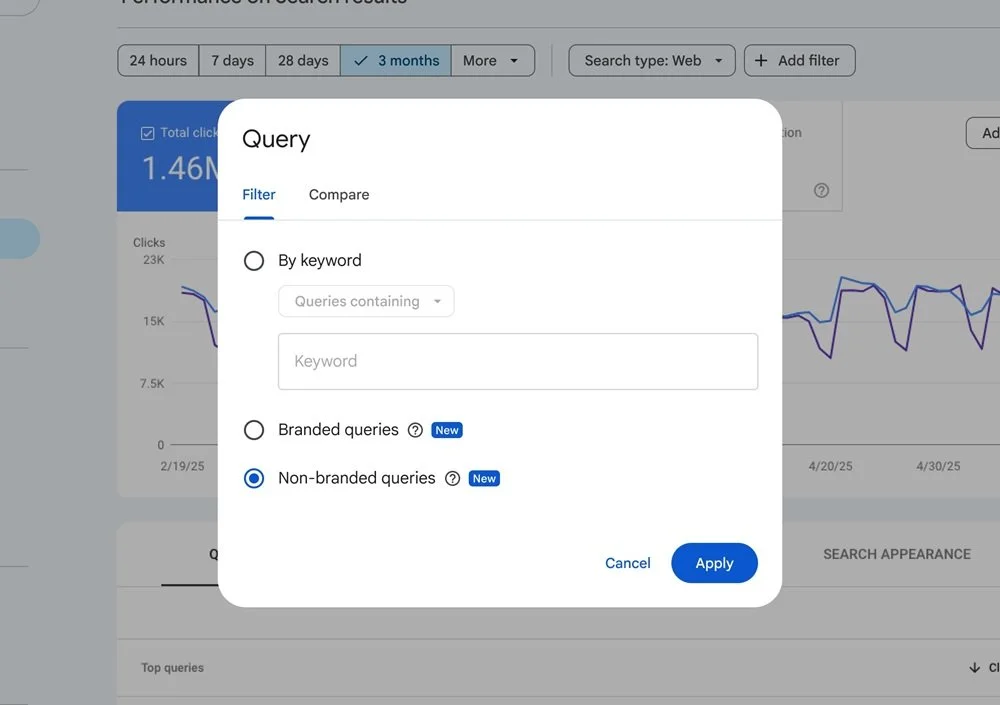

Update vom 20.11.2025: „Branded Queries“-Feature in der Google Search Console

Google hat einen neuen Filter für „Branded Queries“ in der Search Console eingeführt. Im Leistungsbericht kann damit differenziert werden, wie viel des Traffics auf markenbezogene Suchanfragen entfällt. Der Filter erkennt automatisch Begriffe, die mit dem Domainnamen, der Marke oder App-Titeln übereinstimmen. Das soll die Analyse der Markenwahrnehmung in der Suche verbessern und ein gezielteres SEO-Controlling der im KI-Zeitalter wichtiger werdenden Markenerwähnungen unterstützen.

Update vom 17.11.2025: Debatte um Notwendigkeit von GEO-Tools

Die Schließung des GEO-Tools Lorelight – mit dem man die Sichtbarkeit sowie Brand Mentions in LLMs messen konnte – hat eine Branchendebatte rund um KPIs und die Notwendigkeit von AI-SEO-Tools ausgelöst. Lorelight-Gründer Benjamin Houy begründet das Ende von Lorelight damit, dass es keine spezifischen Tools brauche, die die Sichtbarkeit von Websites in LLMs wie ChatGPT, Perplexity oder Claude analysieren. Er argumentiert, dass spezialisierte GEO-Tools überflüssig seien, da Marken, die bereits über qualitativ hochwertige Inhalte, starke Autorität und klare Markenführung verfügen, auch in AI-basierten Suchergebnissen bereits gut abschneiden.

Search Engine Journal fasst die Meinung einiger SEO-Expert:innen zusammen, die dem entgegen betonen, dass die Analyse von Sichtbarkeit und Performance in KI-generierten Antwortumgebungen nicht ohne (spezialisierte) Monitoring-Tools möglich sei.

Die Debatte zeigt grundlegende Meinungsunterschiede über die zukünftige Rolle von SEO auf. Zwar hat Houy grundsätzlich Recht, allerdings greift seine Annahme unserer Meinung nach etwas zu kurz. Autorität und klare Markenführung entstehen nicht von selbst, sondern müssen gezielt aufgebaut und strategisch begleitet werden. GEO-Tools bieten dazu gerade für kleinere oder spezialisierte Marken wertvolle Einblicke, um die Sichtbarkeit in KI-Tools zu steigern und sich gegenüber etablierten Wettbewerbern zu etablieren. Wer auf diese Hilfsmittel verzichtet, riskiert blinde Flecken in der eigenen Performance-Analyse.

Alexander Beth

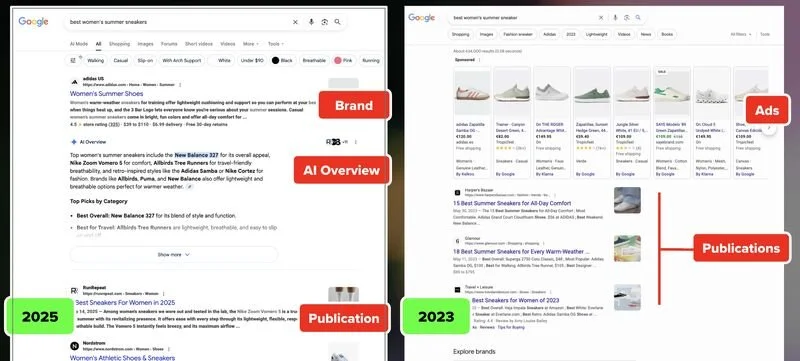

Update vom 14.11.2025: Anstieg von Zero Click Searches und deren Ursachen

Aleyda Solís weist auf LinkedIn darauf hin, dass nicht nur AI Overviews für „Zero Click“-SERPs und das Auseinanderdriften von Google und unabhängigen Seiten verantwortlich sind. Zwei weitere Hauptfaktoren sind laut ihr:

Die wachsende Dominanz von Google-eigenen SERP-Elementen oberhalb der organischen Treffer, wie Produkt- oder Videokarussells, die oft auf Google-eigene Dienste (z. B. YouTube) oder Partnerseiten wie Reddit verlinken.

Die zunehmende Bevorzugung großer Marken und Plattformen gegenüber kleineren oder unabhängigen Seiten, sowohl in traditionellen als auch in AI-basierten Suchergebnissen.

Beobachtungen aus SERP-Vergleichen zwischen 2023 und 2025 belegen diese Verschiebung laut Aleyda Solís.

Die Annahmen reihen sich in die Erkenntnisse von Seer Interactive aus der vergangenen Woche ein: Googles Selbstreferentialität stellt einen der größten Einflussfaktoren auf das veränderte Nutzerverhalten in der Google-Suche dar. Für SEO-Content ist es heute umso wichtiger, möglicherweise gesunkenen organischen Traffic in Relation zu setzen und nicht allein das Google-Ranking als Erfolgsindikator heranzuziehen.

Henry Seyffert

Update vom 13.11.2025: Best Practices für den Google AI Mode

Sistrix-Gründer Johannes Beus hat in einer aktuellen Untersuchung die 100 am häufigsten zitierten URLs im Google AI Mode betrachtet – zentrale Erkenntnis: Entscheidend für die Auswahl als Quelle ist nicht das Thema, sondern die Struktur der Webseite. Drei Merkmale sind laut seiner Analyse ausschlaggebend:

Antwort-zentriertes Design: Inhalte sind klar gegliedert und modular aufgebaut, statt in langen Textblöcken präsentiert. Die KI braucht kleinteilige, logisch strukturierte Bausteine, wie Schritt-für-Schritt-Anleitungen, Tabellen etc. – wer SEO-Content erstellt, muss damit rechnen, dass Google die Seite inhaltlich auseinandernimmt und neu zusammensetzt.

Autorität und Aktualität: Die Seiten zeigen E-A-T (Expertise, Authoritativeness, Trustworthiness) sowohl für Bots als auch für Nutzer:innen. Menschliche Signale zählen also nach wie vor: Die erfolgreichsten Seiten geben im Quellcode Urheber der Artikel, Stimmen von Expert:innen und Erstellungs- und Aktualisierungsdaten der Artikel an. Jahrelang nicht aktualisierte Blogposts sind für die KI-Suche praktisch wertlos.

Technische Zugänglichkeit: Die Inhalte sind so aufbereitet, dass KI-Systeme sie problemlos verarbeiten können. Die meistzitierten Seiten sind für künstliche Intelligenz genauso gut lesbar wie für Menschen. Inhaltsverzeichnisse verlinken mit Sprungmarken auf die passenden Artikel-Sections und Tabellen sind wirklich als Tabellen und nicht als Screenshots eingebunden.

Update vom 11.11.2025: Quellenauswahl bei ChatGPT

Eine groß angelegte Analyse von Josh Blyskal und Jasman Singh aus über 220 Millionen ChatGPT-Antworten zeigt: ChatGPTs Quellenwahl orientiert sich kaum an klassischen SEO-Rankings. Zwar nutzen LLMs häufiger Inhalte aus oberen SERP-Positionen (27,5 % aus Position 0), aber der Unterschied zu Position 1 (27,2 %) ist minimal. Die Auswahl folgt eher semantischer Relevanz als Rankinglogik.

Nur 34,4 % der Antworten enthalten Inhalte von Google-Rankings, und fast 46 % stammen aus Quellen außerhalb der Top 10. Das bestätigt, dass LLMs Inhalte anders priorisieren als klassische Suchmaschinen.

Die Studie zeigt auch, dass die erste Suchanfrage im Query Fan Out in rund 67 % der Fälle den größten Anteil an den Quellen hat, die ChatGPT letztlich zitiert. Seiten sollten daher möglichst gezielt auf typische Einstiegsfragen optimiert sein und diese klar, modular und technisch sauber beantworten.

Alexander Beth

Update vom 10.11.2025: Geringere Klickraten in den Google-Suchergebnissen

Eine neue Analyse der Marketingagentur Seer Interactive, basierend auf über 25 Mio. Impressionen, zeigt, dass es in den Google-Suchergebnissen seit Mitte 2024 zu einem deutlichen Rückgang in den Klickzahlen kam. Bei informativen Suchanfragen, in denen AI Overviews ausgespielt wurden, fiel die organische Klickrate um 61 %, bezahlte Anzeigen verloren 68 %.

Zudem fällt auf, dass selbst Suchanfragen, in denen keine KI-Übersicht gezeigt wird, ein Minus von 41 % verbuchten. Search Engine Land führt das auf die gewachsene Relevanz von KI-Suchen und Social Search zurück.

Besonders bemerkenswert ist der Rückgang der organischen Klickrate bei Suchanfragen ohne AI Overviews. Das legt nahe, dass die gesamte Nutzerwahrnehmung und -interaktion in den Suchergebnissen im Wandel ist. Die veränderte Struktur der SERPs mit visuell dominanteren Inhalten oder erweiterten Snippets scheint auch ohne KI-Übersichten zu einer geringeren Klickneigung zu führen. Der SEO-Fokus verschiebt sich zunehmend weg von Klickzahlen hin zu Sichtbarkeit und Markenpräsenz.

Alexander Beth

Update vom 07.11.2025: Sinkende Relevanz der Originalsprache in der KI-Suche

In einem LinkedIn-Post macht Johannes Beus auf eine neue Konkurrenzsituation im KI-Suchumfeld aufmerksam: Google bezieht im AI-Modus zunehmend nicht-deutschsprachige Inhalte, übersetzt diese automatisch via translate.google.com und verwendet sie als Quellen für deutschsprachige Antworten. In der Analyse machen solche Quellen bereits rund 5 % aller Quellenlinks für den deutschen Markt aus – mit steigender Tendenz.

Fazit: Content konkurriert künftig sprachübergreifend, relevante Inhalte aus aller Welt können sichtbar werden – unabhängig von der Originalsprache.

Update vom 06.11.2025: Suchintention im Fokus und die Nutzung von PAAs

In einem neuen LinkedIn-Post kritisiert Mark Williams-Cook, dass viele SEO-Verantwortliche bei PAA- und KI-Queries immer noch auf „Search Volume“ fixiert sind. Für Longtail-Anfragen sei jedoch nicht das Suchvolumen entscheidend, sondern die dahinterstehende Suchintention.

Beispiel: Sieben semantisch fast identische Fragen zu Tinnitus und Ohrstöpseln ergeben zwar jeweils „0 Volumen“, stehen aber alle für dieselbe Nutzerabsicht.

In Summe kann daraus ein relevantes Traffic-Potenzial entstehen, das mit klassischen Keyword-Tools unterschätzt wird.

Bleiben wir beim Thema Suchintention: In einem weiteren LinkedIn-Post hebt SEO-Experte Mark Williams-Cook hervor, dass „People Also Ask“-Fragen (PAAs) als Ausdruck von Suchintention und nicht als reine Keywords verstanden werden sollten. Anhand von Fragen zu Doc Martens (z. B. „Can a 40 year old woman wear Dr. Martens?“ oder „Do Doc Martens support LGBTQ?“) erklärt er, wie sich Inhalte besser strukturieren lassen:

durch Einbindung von Produkt- und Social-Media-Teams sowie

durch sichtbare Positionierung von Markenwerten (z. B. LGBTQ-Support).

Ziel ist es, nicht eindimensional zu antworten, sondern Nutzerintentionen ganzheitlich aufzugreifen.

SEO heißt heutzutage: Suchintentionen verstehen, entsprechende Inhalte mit Mehrwert erzeugen und gezielt über verschiedene Kanäle zu transportieren. Die Suche wird im KI-Zeitalter zunehmend multimodal. Nutzer:innen informieren sich nicht nur über Suchmaschinen, sondern erwarten – ebenso wie Algorithmen – konsistente Signale über verschiedene Kanäle (Social Media, Produktseiten, Foren etc.).

Wer relevant bleiben will, muss Content strategisch, kanalübergreifend, nutzerzentriert und im entsprechenden Kontext denken.

Henry Seyffert

Update vom 05.11.2025: Tracking-Problematik der LLMs

In einem Beitrag auf LinkedIn weist Lily Ray auf ein zentrales Problem bei der Nutzung von LLM-Tracking-Tools hin: Die zunehmende Personalisierung von LLMs (z. B. durch Standort, Interessen oder bisherige Interaktionen) führt dazu, dass ein und derselbe Prompt zu unterschiedlichen Antworten führt.

In Tests zeigte sich, dass ChatGPT Anfragen lokalisiert („NYC store“) und damit andere Ergebnisse liefert als Tools mit breiterem Fokus. Das stellt Tracking-Anbieter vor Herausforderungen – insbesondere, solange es keine dedizierten Analyseplattformen wie eine „OpenAI Search Console“ oder entsprechende Funktionen in der GSC gibt.

Ohne Zugriff auf echte Nutzerdaten (z. B. Logfiles oder ChatGPT-spezifische User-Agents) sind Reporting-Plattformen faktisch blind für die tatsächlichen LLM-Nutzerpfade. Selbst mit ausgefeilten Tools bleibt die Sichtbarkeit begrenzt, wenn keine echten Nutzungsdaten einbezogen werden. "Intent-Tracking" ersetzt nicht das tatsächliche Nutzerverhalten, sondern zeigt nur Tendenzen. Über die Aussagekraft von Prompt- und LLM-Tracking bestehen geteilte Meinungen.

Alexander Beth

Update vom 04.11.2025: Relevanz von Markenerwähnungen

In einem aktuellen Podcast zeigt Ahrefs anhand eigener Daten, dass Markenerwähnungen auf Drittseiten – auch ohne Backlink – die Sichtbarkeit in KI-gestützten Suchergebnissen signifikant erhöhen können. Search Engine Journal greift diese Erkenntnisse auf und hebt hervor, dass sich Markenerwähnungen zu einem wichtigen Faktor im modernen Off-Page-SEO entwickeln. Besonders im kommerziellen Umfeld tauchen Brands mit vielen Fremderwähnungen bevorzugt in KI-Antworten auf.

Die Daten von Ahrefs zeigen, dass Relevanz und Vertrauen zunehmend über Reputation vermittelt werden. Backlinks bleiben zwar wichtig, bloße Erwähnungen – beispielsweise in Fachmedien oder Blogs – werden allerdings immer mehr zu einer neuen Währung. Diese Entwicklung stärkt auch den Stellenwert verschiedener Bereiche wie PR und Outreach und sollte in der eigenen Strategie für den Markenaufbau berücksichtigt werden.

Henry Seyffert

Update vom 03.11.2025: Grounding vs. Query Fan Out

In einem Beitrag auf LinkedIn erklärt Mark Williams-Cook einen wichtigen Unterschied im Kontext von KI und SEO:

„Grounding“-Suchanfragen dienen der gezielten Verifikation oder Informationsbeschaffung zum konkreten Prompt und sind auf wenige Suchvorgänge beschränkt.

„Query Fan Out“ löst im Gegensatz dazu in tiefgreifenden Recherchemodi zahlreiche Suchanfragen aus, um ein Thema umfassend aus verschiedenen Perspektiven zu beleuchten.

Beim sogenannten "Grounding" geht es um Punktgenauigkeit – z. B. „Stimmt diese Information?“. "Query Fan Out" verfolgt das Ziel ein breites Verständnis und nicht nur die Verifikation einer Information zu erlangen. Beide Ansätze sollten nicht miteinander verwechselt werden.

Updates aus dem Oktober 2025

Update vom 29.10.2025: Bedeutung strukturierter Daten für die KI-Suche

Update vom 27.10.2025: "Query Groups" in der Google Search Console

Update vom 22.10.2025: Bedeutung des User-Agents "ChatGPT User"

Update vom 15.10.2025: Mehr AI Overviews in Googles „People Also Ask“

Update vom 08.10.2025: Google AI Mode in Deutschland verfügbar

Update vom 03.10.2025: Anzahl der Reddit-Zitierungen in ChatGPT eingebrochen

Update vom 02.10.2025: Identifizierung von Web-Suchanfragen bei ChatGPT

Update vom 29.10.2025: Bedeutung strukturierter Daten für die KI-Suche

In einem LinkedIn-Beitrag betont Hanns Kronenberg die zentrale Rolle strukturierter Daten für moderne KI-Systeme. Er widerspricht der These „KI braucht nur Text“ und nennt zwei entscheidende Gründe: Erstens helfen strukturierte Daten beim indirekten Training von LLMs über SERP-Elemente wie Rich Snippets oder Panels. Zweitens werden sie direkt in RAG-Systemen (z. B. bei Google AI, ChatGPT) für präzise Antworten genutzt – inklusive Quellennennung und Zitatfunktion. Sein Fazit: Strukturdaten sind heute ein SEO-Relikt mit neuem Wert als KI-Relevanzbooster.

Strukturierte Daten sind ein strategisches Bindeglied zwischen Content und KI-Systemen. Während klassische SEO sich lange auf Ranking-Optimierung konzentriert hat, rücken nun semantische Klarheit und Maschinenverständlichkeit in den Vordergrund.

Das bedeutet: Wer strukturierte Daten einsetzt, erhöht nicht nur die Sichtbarkeit in der Suche, sondern auch die Wahrscheinlichkeit, in KI-generierten Antworten aufzutauchen. Das ist ein entscheidender Vorteil angesichts der wachsenden Bedeutung von AI Overviews, RAG-Systemen und Zero-Click-Searches.

Alexander Beth

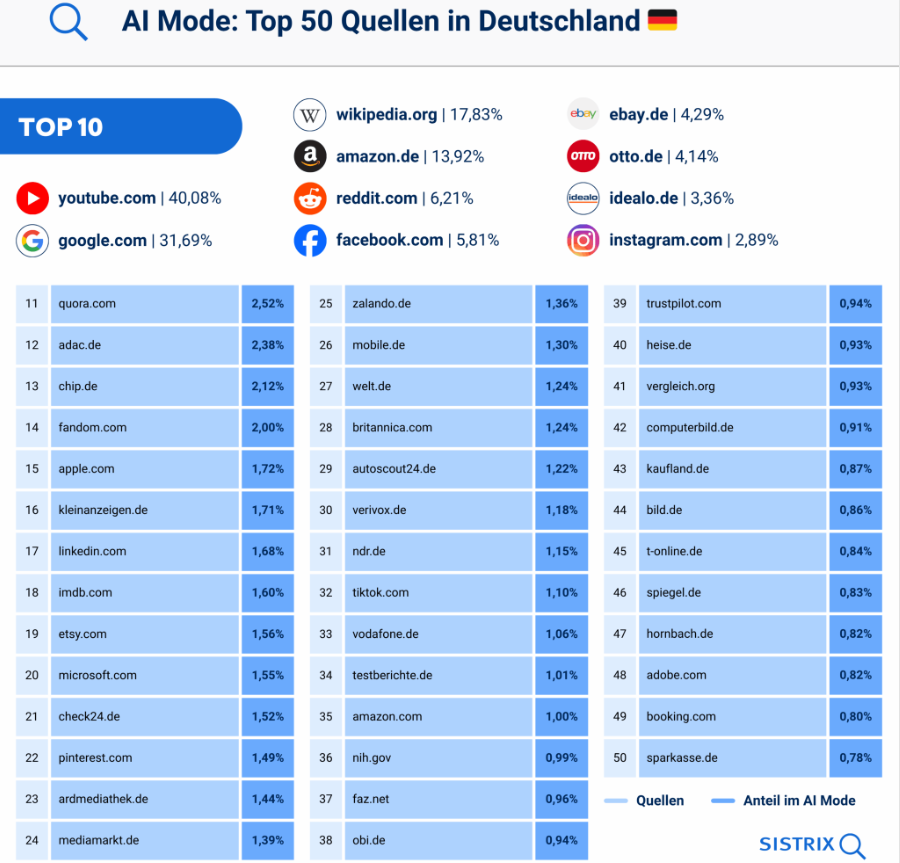

Update vom 28.10.2025: Quellenangaben im Google AI Mode

Laut einer Analyse von Johannes Beus stammen über 40 % der Quellenangaben im Google AI Mode (Deutschland) von Google-eigenen Diensten. YouTube führt die Liste an, gefolgt von Google Translate. Erst auf Platz 3 folgt Wikipedia mit 17 % Anteil. Die 50 häufigsten Quellen im AI Mode überschneiden sich teilweise mit den organisch sichtbarsten Domains, weisen jedoch auch klare Verschiebungen auf – etwa zugunsten von Marken wie Vodafone oder ADAC. Auffällig: In den meisten Fällen wird auf Quellen ohne klickbaren Link verwiesen – die Nennung erfolgt lediglich als Text. Die Daten unterstreichen Googles starke Selbstreferenzierung im eigenen KI-Modus.

Update vom 27.10.2025: "Query Groups" in der Google Search Console

Google führt in der Search Console sogenannte Query Groups ein, die KI-gestützt ähnliche Suchanfragen basierend auf ihrem Search Intent bündeln. Diese Gruppierung erleichtert soll die Analyse mit zusammengefassten Leistungsdaten erleichtern. Die Funktion wird im Leistungsbericht angezeigt und nach Klickzahl sortiert – der Rollout erfolgt schrittweise, zuerst für Properties mit großem Klickvolumen. Ein Ranking-Einfluss besteht laut Google nicht.

Durch die KI-basierte Gruppierung verwandter Suchanfragen nach Suchintention könnt ihr schneller Muster und Nutzerbedürfnisse erkennen, ohne einzelne Keywords mühsam analysieren zu müssen. Dies vereinfacht nicht nur die Content-Optimierung, sondern fördert auch eine fokussiertere, intent-basierte Seitenstruktur. Da KI-Chats die Suchanfragen immer mehr verlängern und die Varianz steigt, dürfte die Funktion besonders für größere Websites mit hohem Traffic eine signifikante Zeitersparnis und präzisere strategische Auswertungen ermöglichen. Kritisch zu beobachten bleibt die Transparenz der Gruppierungslogik.

Henry Seyffert

Update vom 25.10.2025: Funktionsweise des Atlas-Browser

Laut einem LinkedIn-Post von Chris Long basiert die Suchfunktion im Atlas-Browser von ChatGPT stark auf Google-Suchergebnissen. SEO-Experten wie Barry Schwartz und Pedro Dias stellten eine signifikante Übereinstimmung zwischen Atlas-„Search“-Ergebnissen und Google-Rankings fest.

Jean-Christophe Chouinard entdeckte zudem, dass Anfragen aus Atlas in den Serverlogs als Googlebot-Zugriffe erscheinen. Dies deutet darauf hin, dass Atlas Google nicht nur als Datenquelle nutzt, sondern sich aktiv in dessen Infrastruktur einklinkt – etwa durch Tools wie SERPAPI.

Ergänzend zur Diskussion um den Atlas-Browser von OpenAI relativiert Dan Hinckley die Annahme, Atlas würde aktiv Google scrapen. Er betont: Atlas ist ein Browser, kein Crawler oder Scraper, das heißt Nutzer:innen greifen lediglich über Atlas auf Google zu, ähnlich wie über Chrome.

Update vom 23.10.2025: Bedeutung des OpenAI Browser "Atlas"

Bei LinkedIn erläutert Josh Blyska die strategische Bedeutung von OpenAIs neuem Atlas-Browser, der eine technologische Zeitenwende für SEO markieren könnte. Anders als herkömmliche Browser greift Atlas nicht nur auf Websites zu – er interagiert live mit dem JavaScript-gerenderten Frontend.

DOM-Elemente, Produktfilter und strukturierte Daten werden direkt genutzt, um Antworten zu liefern. Dies sei ein Vorgeschmack auf eine „agentenbasierte“ Webnutzung, in der Geschwindigkeit, Interaktivität und Skriptbarkeit der Seiten entscheidend werden. Gewinner dieser Entwicklung sind laut Josh Seiten, die strukturierte Daten, APIs und schnelle, nutzerfreundliche Oberflächen bieten und nicht bloß solche mit guter Crawlability.

Update vom 22.10.2025: Bedeutung des User-Agents "ChatGPT User"

In einem LinkedIn-Beitrag weist Dan Hinckley auf die Bedeutung des User-Agents „ChatGPT User" hin. Dieser erscheint in Server-Logs, wenn ChatGPT Inhalte einer Website für reale Nutzeranfragen abruft. Website-Betreiber können diese Logdaten nutzen, um zu erkennen, welche Inhalte von ChatGPT aktiv zitiert oder verarbeitet werden.

Besonders wertvoll: Die Analyse zeigt nicht nur Seitenaufrufe, sondern auch die Position im Funnel, in dem ChatGPT Inhalte präsentiert – etwa ob Awareness-, Consideration- oder Conversion-Inhalte übermittelt werden. Für SEOs bedeutet das: Wer gezielt Seiten optimiert, die von ChatGPT erfasst und verwendet werden, kann konkret Einfluss auf die AI-getriebene Customer Journey nehmen.

Über die Logfiles können über den User-Agent wertvolle Informationen gewonnen werden. Zum einen helfen diese Daten dabei, reale Einblicke in die Funktionsweise der KI-Suche und die Relevanz des eigenen Angebots zu erhalten. Zum anderen können relevante Seiten identifiziert und gezielt für die eigenen Ziele überarbeitet werden. Beispielsweise können OnPage-Inhalte gezielt überarbeitet und stärker auf die Zielgruppe und die Funnelposition zugeschnitten werden. So kann das Maximum aus den Klicks herausgeholt werden.

Alexander Beth

Update vom 21.10.2025: Sinn und Unsinn von Prompt-Trackern

Mark Williams-Cook äußert sich kritisch zur wachsenden Praxis, AI Prompt Visibility Tracking im Sinne des klassischen Paradigmas "Ranktracking" zu verwenden. Prompts sollten nicht wie klassische Keywords verstanden und der Ranktracking-Logik unterzogen werden. Er bezeichnet solche Ansätze als „teure Zeitverschwendung“, da LLMs nicht deterministisch ranken, sondern Inhalte kontextuell und dynamisch generieren.

Williams-Cook plädiert dafür, den Fokus von Rankings auf die Frage zu verschieben, wie AI-Modelle Marken, Produkte und Services inhaltlich „verstehen“ – ein Paradigmenwechsel vom messbaren SERP-Ranking hin zu einer qualitativen, AI-basierten Markenwahrnehmung. In Zukunft, so seine These, werde „Brand“ das sein, was KI über ein Unternehmen versteht, nicht was Menschen aktiv darüber sagen oder schreiben.

Aufgrund der gestiegenen Dynamik innerhalb von KI-Suchen hat Mark Williams-Cook hier einen validen Punkt. Prompts sollten nicht in eine Keyword-Logik überführt werden. Dennoch ist das Prompt Tacking ein wichtiger Bestandteil, um zu verstehen, wie KI-Modelle Inhalte interpretieren und wiedergeben. Zudem ist es ein erster Anhaltspunkt für die Optimierung im Zeitalter der KI-Suche.

Henry Seyffert

Update vom 15.10.2025: Mehr AI Overviews in Googles „People Also Ask“

Laut Marc Williams-Cook und Daten von AlsoAsked werden mittlerweile immer mehr Antworten auf Basis von KI-Übersichten im „People Also Ask“-Bereich (ausklappbares FAQ) in den Google Suchergebnissen angezeigt. Seit Juli 2025 ist der Anteil von 17,8 % erst auf 26,6 % im August und dann auf 37,9 % im September gestiegen. Damit hat sich der Anteil in drei Monaten mehr als verdoppelt.

Die Daten zeigen, dass Google seine KI-Features an so vielen Stellen wie möglich integrieren möchte. Ob die Anteile der AI Overviews sich so weiterentwickeln oder möglicherweise wieder sinken, muss abgewartet werden. Für die Content-Erstellung heißt das aber, dass FAQ-Sections z. B. am Ende von Blogbeiträgen weiter an Stellenwert für die Suchmaschinenoptimierung verlieren.

Henry Seyffert

Update vom 13.10.2025: Googles „Goldmine“-System

Shaun Anderson hat das 2024 in Googles Content Warehouse Leak bekannt gewordene System „Goldmine“ analysiert, das als Auswahlmechanismus für die Inhalte von Suchmaschinenergebnissen (SERP-Snippets) dient. Demnach analysiert Goldmine Inhalte aus verschiedenen Feldern einer Webseite – darunter <title>, H1, URL, Meta-Description, Absätze und Listen – und wählt auf Basis semantischer Qualität und Passgenauigkeit den besten Text für die Darstellung in den Suchergebnissen aus.

Dabei werden diese „Text Candidates“ auf Basis der Konsistenz zwischen URL und Content, Formatierungen wie Fettungen sowie ihrer Position im Text bewertet. Goldmine arbeitet dabei im Zusammenspiel mit anderen Systemen des Google Algorithmus wie NavBoost (Userverhalten), Radish (Featured Snippets) und SnippetBrain (Snippet-Auswahl), um möglichst relevante, vertrauenswürdige und ansprechende Vorschautexte zu generieren.

Das „Goldmine“-System macht deutlich, wie eng die technische und semantische Suchmaschinenoptimierung verzahnt sind. Klassische Signale wie Metadaten und H1 behalten zwar ihre Bedeutung, es reicht aber nicht aus, sie losgelöst vom restlichen Content zu betrachten. Wer die Anzeige seiner Suchmaschineneinträge gezielt steuern will, sollte seine OnPage-Inhalte so gestalten, dass sie auch als mögliche SERP-Snippets Vertrauen und Relevanz signalisieren.

Alexander Beth

Update vom 09.10.2025: State of AI Report 2025

Der State of AI Report 2025 wurde veröffentlicht. Der jährlich erscheinende KI-Bericht von Investor Nathan Benaich und Air Street Capital gilt seit 2018 als eine der meistgelesenen und vertrauenswürdigsten Analysen zentraler Entwicklungen im Bereich der Künstlichen Intelligenz. Für 2025 wurden folgende Key-Takeaways vorgestellt:

Technologische Führerschaft: OpenAI bleibt knapp vorn, doch chinesische Anbieter wie DeepSeek, Qwen und Kimi schließen bei Reasoning- und Coding-Aufgaben auf.

Reasoning im Fokus: Fortschritte durch Reinforcement Learning, rubrikbasierte Belohnungen und verifizierbares Reasoning führen zu selbstkorrigierenden, planenden KI-Systemen.

KI als Forschungspartner: Tools wie DeepMind’s Co-Scientist und Stanford’s Virtual Lab generieren, testen und validieren Hypothesen eigenständig.

Biotechnologie: Profluent’s ProGen3 zeigt, dass Skalierungsgesetze nun auch für Proteine gelten.

Embodied AI: Systeme wie Molmo-Act (AI2) und Gemini Robotics 1.5 (Google) führen Schritt-für-Schritt-Planung („Chain-of-Action“) in die physische Welt ein.

Kommerzialisierung: 44 % der US-Unternehmen zahlen für KI-Tools (2023: 5 %), durchschnittliche Verträge liegen bei 530.000 $. KI-first-Startups wachsen 1,5× schneller.

Verbreitung im Alltag: 95 % der Fachkräfte nutzen KI beruflich oder privat, 76 % zahlen selbst für Tools, viele berichten von nachhaltigen Produktivitätsgewinnen.

Industrielle KI-Ära: Multi-GW-Rechenzentren wie Stargate entstehen – Stromversorgung wird zum limitierenden Faktor. Finanzierung u. a. durch Staatsfonds aus den USA, China und den Vereinigten Arabischen Emiraten.

Geopolitik: USA setzen auf „America-first-AI“, China forciert Open-Weights-Modelle und Chip-Entwicklung, EU verliert mit dem AI Act an Zugkraft.

KI-Sicherheit: Fokus verschiebt sich von Existenzrisiken hin zu praktischer Zuverlässigkeit, Cybersicherheit und Governance. Alignment wird zunehmend simulierbar, Budgets für externe Sicherheitsteams bleiben knapp.

Update vom 08.10.2025: Google AI Mode in Deutschland verfügbar

Der Google AI Mode (KI-Modus) ist ab sofort in Deutschland, Österreich und der Schweiz sowie über 35 weiteren Ländern verfügbar. Anders als bei den AI Overviews, die in den Google Suchergebnissen angezeigt werden, ersetzt der AI Mode die klassische Ergebnissseite und ist als eigener Tab wie Bilder, Videos etc. zugänglich. Damit bietet Google auf Basis des eigenen LLMs Gemini direkt KI-generierte Antworten mit der Möglichkeit zu Folgefragen. Ein flächendeckender Rollout für alle Nutzer:innen wird wohl noch etwas Zeit in Anspruch nehmen – unter google.com/ai kann die Verfügbarkeit des KI-Modus für den eigenen Account geprüft werden.

Die Einführung des AI Mode für den deutschsprachigen Raum wurde lange erwartet und setzt den Wandel in der Darstellung von Suchergebnissen fort. Eine qualitative Studie von Growth Memo zeigt, dass Nutzer:innen im KI-Modus kaum externe Klicks durchführen. Obwohl in den Antworten im KI-Modus Links integriert sind, hält Google mit dem KI-Modus momentan die Nutzer:innen im eigenen System und verweist sie nur selten weiter auf externe Seiten. Es ist also mit einem weiteren Rückgang des organischen Traffics zu rechnen – insbesondere bei informationsgetriebenen Suchanfragen. Unternehmen und Publisher sollten frühzeitig analysieren, wie sich ihre Sichtbarkeit nun verändert.

Henry Seyffert

Update vom 06.10.2025: Apps in ChatGPT

OpenAI hat auf dem DevDay 2025 interaktive Apps direkt in ChatGPT vorgestellt. Nutzer:innen sollen Anwendungen wie Booking.com, Spotify, Coursera und Figma direkt im Chat nutzen können – etwa um Reisen zu planen, Lerninhalte zu finden oder Designs umzusetzen. Entwickler:innen erhalten dabei mit dem neuen Apps SDK Zugriff auf Tools zur Erstellung eigener Anwendungen. Die Apps sollen kontextabhängig im Chat erscheinen, sich per Spracheingabe steuern und künftig auch monetarisieren lassen. In Europa sind ChatGPT Apps vorerst nicht verfügbar.

Mit der Einführung von Apps in ChatGPT öffnet OpenAI ein neues Ökosystem, das über die Generierung von Inhalten hinausgeht. Mit der Integration von Drittanwendungen versucht OpenAI, ChatGPT zu einer zentralen Plattform für Alltags- und Geschäftsprozesse zu machen – vergleichbar mit einem Betriebssystem. Strategisch stärkt man so die eigene Position im Wettbewerb mit Apple, Google und Microsoft und schafft neue Monetarisierungsoptionen für KI-gestützte Anwendungen.

Alexander Beth

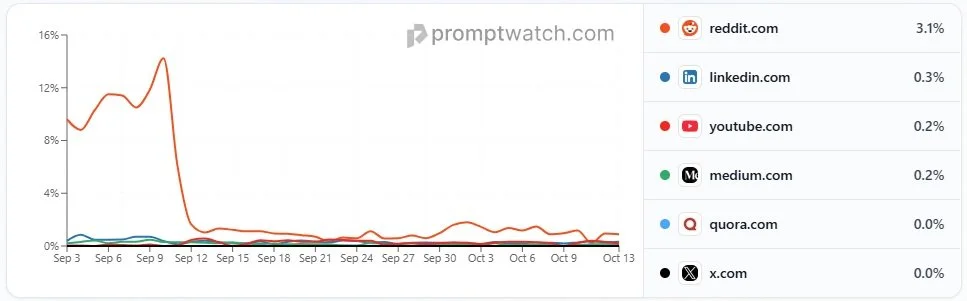

Update vom 03.10.2025: Anzahl der Reddit-Zitierungen in ChatGPT eingebrochen

Wie bereits berichtet, ist Reddit eine der am häufigsten zitierten Quellen in ChatGPT. In den zurückliegenden Wochen ist der Anteil, bei dem Reddit als Quelle für Chatbot-Antworten genannt wird, allerdings von fast 15 Prozent auf unter 1 Prozent gesunken. Das wirkte sich zwischenzeitlich sogar negativ auf den Börsenkurs von Reddit aus.

Ob dahinter ein gezielter Eingriff von OpenAI, verbunden mit einem gesunkenen Vertrauen in die Qualität des Contents von Reddit steht, ist momentan unklar. Als eine mögliche Ursache wird auch Googles Deaktivierung des num=100-Parameters gehandelt. Damit konnten sich Nutzer:innen und SEO-Tools bis Mitte September 2025 bis zu 100 Suchergebnisse auf einer Seite anzeigen lassen – mittlerweile sind nur noch maximal 20 Suchergebnisse auf einmal möglich. Wie Kevin Indig bei G2 schreibt, ranken knapp 60 Prozent der Inhalte, zu denen Reddit in Googles Suchergebnissen auftaucht, außerhalb der Top 20. Das wird als Grund dafür gesehen, dass Reddit nun auch seltener in ChatGPT-Antworten auftaucht.

Update vom 02.10.2025: Identifizierung von Web-Suchanfragen

Ein aktueller SEO-Tipp von Mark Williams-Cook zeigt, wie man nachvollziehen kann, welche Web-Suchanfragen ChatGPT beim Grounding verwendet – also zur Informationsrecherche für seine Antworten. Diese Einblicke können helfen zu verstehen, welche Inhalte von Webseiten in Antworten einfließen und somit SEO-relevant sind.

So funktioniert es (im Chrome-Browser):

F12 drücken, um die Developer Tools zu öffnen

Eine eigene Frage in ChatGPT stellen

Zum Tab „Network“ wechseln

Nach unten scrollen und auf „conversation“ klicken

Auf „Response“ klicken

Nach „search_model_queries“ suchen

Dieses Vorgehen liefert wertvolle Transparenz darüber, wie ChatGPT Websuchen für Grounding-Informationen formuliert und kann als Werkzeug in der AI-SEO-Optimierung genutzt werden.

Es bietet Einblick in die Query-Logik, wodurch sich Hinweise zur Content-Optimierung ableiten lassen. Grounding-Queries dienen beispielsweise zur Orientierung, welche Themenfelder und semantische Cluster abgedeckt werden sollten und wo eventuelle Content-Gaps liegen.

Alexander Beth

Update vom 01.10.2025: Visual Search Fan-Out

Google hat die neue Technik „Visual Search Fan-Out“ vorgestellt, die die Bildersuche grundlegend verbessert. Statt Objekte nur zu erkennen, versteht das System Bilder im Kontext – durch die Kombination von visuellen Details und natürlicher Sprache. Laut David Konitzny auf LinkedIn ermöglicht dies unter anderem:

Interaktive visuelle Exploration: Die KI wandelt Sprachbeschreibungen in konkrete Bildvorschläge um und lernt aus Folgefragen.

Kontextbewusstes Shopping: Produkte lassen sich per Beschreibung nach Stil, Farbe oder Passform finden – ganz ohne Filter.

Präzisere Bilderkennung: Hauptmotiv, Details und Hintergrund eines Bildes werden gemeinsam ausgewertet für relevantere Treffer.

Multimodale Sucheingaben: Die Suche funktioniert flexibel mit Text, Bildern oder Fotos – kombiniert für optimale Ergebnisse.

Ziel ist es, Suchanfragen visuell intelligenter, relevanter und benutzerfreundlicher zu gestalten.

Updates aus dem September 2025

Update vom 22.09.2025: Beschwerde der deutschen Medienbranche

Update vom 15.09.2025: OpenAI-Studie zur Nutzung von ChatGPT

Update vom 14.09.2025: Google deaktiviert “&num=100”-Parameter

Update vom 09.09.2025: Audience Overlap zwischen ChatGPT und Google

Update vom 08.09.2025: AI Visibility Index von Semrush vorgestellt

Update vom 01.09.2025: Wachstum der KI-Nutzung sinkt und traditionelle Suche bleibt dominant

Update vom 30.09.2025: ChatGPT Shopping

OpenAI hat den neuen Instant Checkout für ChatGPT vorgestellt, unterstützt durch das gemeinsam mit Stripe entwickelte Agentic Commerce Protocol (ACP). Damit wird ChatGPT vom reinen Ratgeber zum vollwertigen E-Commerce-Agenten: Nutzer können direkt im Chat Produkte suchen und kaufen – nahtlos, ohne die Konversation zu verlassen. US-Nutzer (Free, Plus, Pro) können bereits bei Etsy shoppen, Shopify folgt bald.

Zentrale Merkmale laut Aleyda Solís:

Produktvorschläge sind organisch und ungesponsert, basierend auf Relevanz, nicht Bezahlung.

Zahlung, Versand und Fulfillment erfolgen über die Systeme der Händler.

ChatGPT fungiert als sicherer Vermittler, nicht als Shop-Betreiber.

Für Händler fällt nur bei erfolgreichem Kauf eine geringe Gebühr an.

Produkte mit Instant Checkout werden nicht bevorzugt gerankt.

Unterstützung derzeit für Einzelartikel, Warenkorb-Funktion geplant.

Händler benötigen einen strukturierten Produkt-Feed gemäß Feed-Spec und ACP-Anbindung.

Ergänzende SEO-Perspektive laut Josh Blyskal:

ChatGPT nutzt keine klassischen Keyword-Felder – Google Shopping-Feeds sind ungeeignet.

Datenfülle entscheidet: Produkte mit vollständig ausgefüllten Feldern (z. B. Material, Gewicht, Preis, Lieferzeit) haben größere Sichtbarkeitschancen.

Das Feld [description] (bis zu 5.000 Zeichen) wird zum Schlüssel für Longtail-Optimierung.

Strategieempfehlung: strukturierte, vollständige und kontextreiche Produktdaten bereitstellen.

Update vom 26.09.2025: ChatGPT Pulse

OpenAI hat mit ChatGPT Pulse eine neue Funktion eingeführt: einen personalisierten täglichen Content-Feed, der auf Chatverläufen, Gedächtnisfunktionen und verbundenen Apps basiert. Laut Dan Hinckley ähnelt Pulse dem Prinzip von Google Discover, bietet jedoch eine tiefer kontextualisierte Ausspielung – direkt basierend auf Nutzerintentionen und -projekten.

Für Publisher eröffnet das neue Potenziale:

Neue Traffic-Quelle: Pulse könnte zu einem relevanten Distributionskanal wie Google Discover werden.

Kontextbasierte Ausspielung: Inhalte können gezielt entlang individueller Nutzerbedürfnisse empfohlen werden.

Kurzlebigkeit, aber hoher Impact: Die Empfehlungen aktualisieren sich täglich und treffen genau den Nutzerbedarf zum richtigen Zeitpunkt.

Pulse steht damit sinnbildlich für eine mögliche Neudefinition von Content-Strategien im KI-Zeitalter.

ChatGPT Pulse geht weit über klassische Empfehlungslogiken wie bei Google Discover hinaus: Die Ausspielung ist personalisierter, kontextnäher und potenziell treffsicherer – direkt entlang der individuellen Projekte und Interessen der Nutzer:innen.

Für Publisher bedeutet das: Inhalte müssen konkret und relevant sein.

Die Schnelllebigkeit des Formats verlangt dabei präzise, sofort nutzbare Inhalte. Pulse könnte so zum Vorbild eines neuen Content-Ökosystems werden, in dem Relevanz nicht mehr über Keywords, sondern über echtes Nutzerverständnis definiert wird.

Henry Seyffert

Update vom 24.09.2025: Weniger Websuchen bei ChatGPT

Laut einer Analyse von Johannes Beus greift ChatGPT aktuell deutlich seltener auf Websuchen zurück – insbesondere bei Nutzung ohne Konto. Der Anteil webgestützter Antworten sank innerhalb von zwei Wochen von über 15 % auf unter 2,5 %.

ChatGPT nutzt Websuchen traditionell als Ergänzung zum internen Wissen, um der Problematik veralteter oder halluzinierter Inhalte entgegenzuwirken. Der Rückgang könnte im Zusammenhang mit Googles restriktiverem Umgang mit dem Crawlen eigener Suchergebnisse stehen. Standardmäßig erfolgt die Websuche über Bing.

Update vom 22.09.2025: Beschwerde der Deutschen Medienbranche

Eine Allianz aus Medien-, Digitalverbänden und NGOs hat bei der Bundesnetzagentur Beschwerde gegen Googles AI Overviews eingereicht. Laut der VAUNET verletzen die KI-generierten Suchergebnisse den Digital Services Act (DSA), gefährden die Medienvielfalt und führen zu Reichweiten- sowie Einnahmeverlusten unabhängiger Medien. Kritisiert werden insbesondere Intransparenz und die Verbreitung potenziell fehlerhafter Inhalte. Die Allianz fordert regulatorische Maßnahmen und mögliche Sanktionen durch die EU-Kommission.

Bei der Beschwerde handelt es sich um die erste koordinierte Aktion dieser Größenordnung aus Deutschland – dahinter stehen weite Teile der deutschen Medienlandschaft. Vaunet und seine Unterverbände vertreten die Interessen der privaten Radio- und TV-Sender sowie der Print- und Buchverlage. Darunter sind auch Branchengrößen wie RTL, ProSiebenSat1, Axel Springer und Bertelsmann.

Update vom 20.09.2025: "Fast SEO" = der neue Weg?

Laut Tim Soulo (CMO bei Ahrefs) endet das Zeitalter des "Evergreen SEO Content" – stattdessen beginnt die Ära des „Fast SEO“.

Hintergrund: Viele allgemeine Themen sind längst durchoptimiert und gelten als „Common Knowledge“, weshalb Google häufiger direkt KI-Antworten liefert.

Relevanz ergibt sich nun aus aktuellen Trends, deren Content Google (noch) nicht automatisiert beantworten kann – was Publishern einen strategischen Vorsprung verschafft. Content-Teams sollten daher eher wie Newsrooms agieren: schnell, aktuell und trendfokussiert.

Tim Soulo trifft mit seiner Einschätzung einen Nerv: Evergreen Content war lange effektiv, führte aber oft zu eintönigem Einheitsbrei ohne Mehrwert. Viele Inhalte in den SERPs ähneln sich stark und sind austauschbar – KI-Zusammenfassungen wirken hier fast wie eine Bereicherung.

Der „Fast SEO“-Ansatz fordert nun mehr Relevanz, Aktualität und fundierte Beiträge mit echter Expertise statt Wiederholungen. Das verändert den Anspruch an Content-Strategien grundlegend. Aus Nutzersicht können wir diesen Ansatz nur begrüßen.

Alexander Beth

Update vom 18.09.2025: Gemini direkt im Google-Browser

Laut Marie Haynes integriert Google seine Gemini-KI direkt in den Chrome-Browser – laut Google das größte Chrome-Update überhaupt. Die Funktion ist vorerst nur für Mac und Windows verfügbar, nicht aber für Chromebooks. Nutzer:innen können per KI-Button mit Gemini über die aktuell besuchte Seite interagieren.

Gemini agiert dabei als „Agentic browsing assistant“: Termine buchen, Produkte finden, Tabs zusammenfassen, Browserverlauf analysieren und mit Google-Diensten (z. B. Maps, YouTube, Kalender) interagieren. Auch KI-gestützte Suchanfragen direkt aus der Adressleiste starten bald in den USA.

Die Integration von Gemini direkt im Browser ist das größte Chrome-Update seit Langem. Google verzeichnet noch immer eine wahnsinnig große Nutzerbasis. Schafft es der Konzern, die eigenen KI-Lösungen in die hauseigenen Systeme niedrigschwellig zu integrieren sowie die Akzeptanz und Nutzung zu pushen, kann sich Google gegen immer stärkere Konkurrenz behaupten.

Henry Seyffert

Update vom 16.09.2025: Wirksamkeit von Reddit als SEO-Kanal

Erwan Gauthier teilt Erkenntnisse aus einem dreimonatigen Reddit-Experiment bei lemlist. Die Datengrundlage:

12 Threads

28 Diskussionen

+22 % Traffic

+20 % höhere Conversion

Das Experiment von lemlist zeigt Reddit als effektiven, aber anspruchsvollen Growth-Kanal.

Erkenntnisse: Jede Subreddit hat eigene „Kulturregeln“ inkl. unterschiedlicher Moderatorenaktivität. Automatische Antworten (selbst mit GPT) führen schnell zur Sperre und kurzfristige Leads gibt es kaum – dafür langfristige SEO- und AI-Synergien, z. B. durch Sichtbarkeit in ChatGPT-Antworten.

Nachdem vor allem Reddit als häufig zitierte Quelle bei ChatGPT auftaucht, wurden Diskussionen über das SEO-Potenzial des Kanals – sowohl als Trust- als auch als Trafficquelle – laut.

Entgegen vieler Meinungen ist Reddit als Trafficquelle kein „Quick Win“.

Es zeigt sich, dass das Potenzial des Kanals bisher nur mit echtem, menschlichem Engagement gehoben werden kann.

Alexander Beth

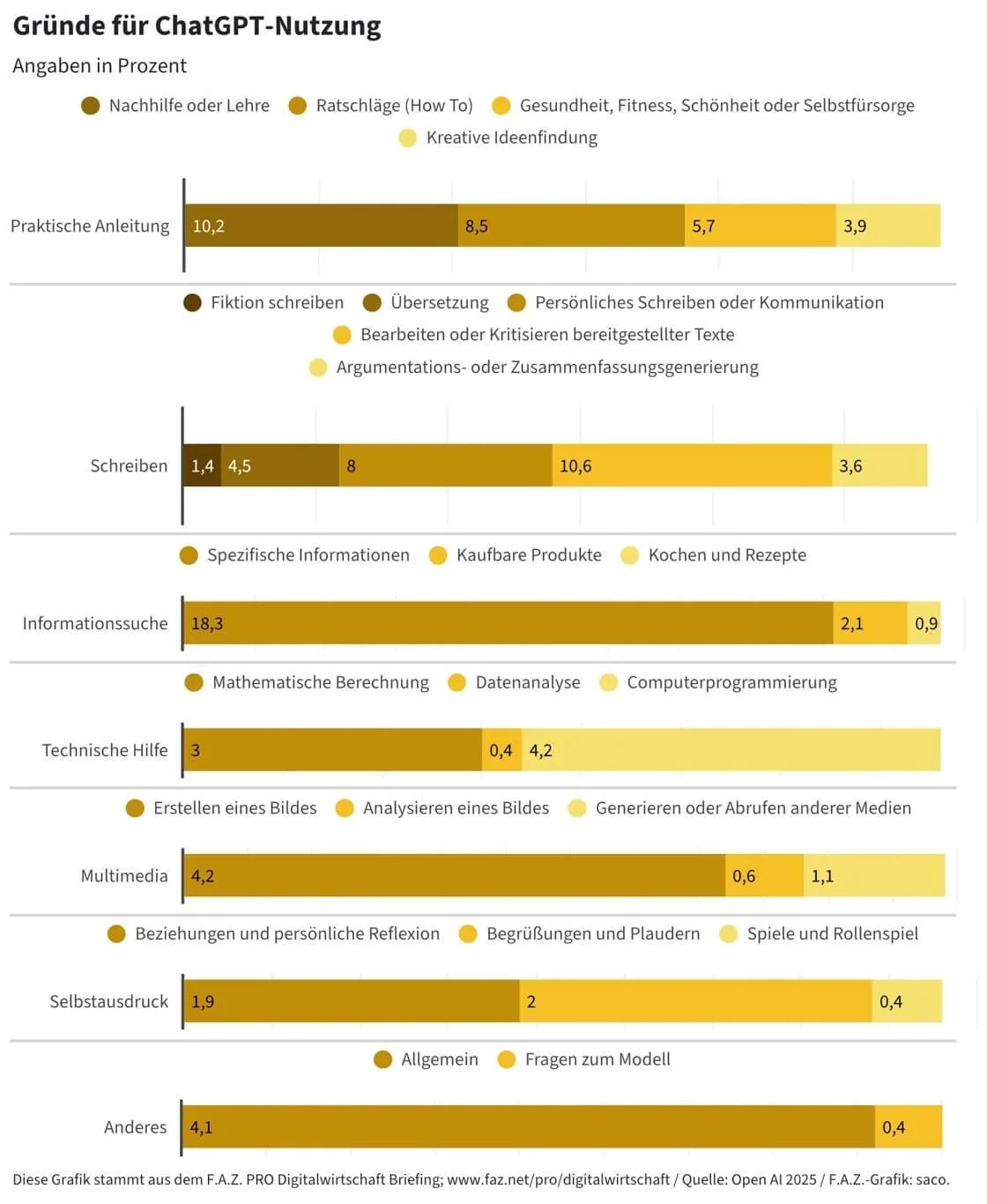

Update vom 15.09.2025: OpenAI-Studie zur Nutzung von ChatGPT

In einer neuen Studie von OpenAI, durchgeführt mit Harvard-Ökonom David J. Deming, wurden 1,5 Mio. Chatverläufe zwischen Mai 2024 und Juni 2025 analysiert.

Die Ergebnisse zeigen, dass die private Nutzung von ChatGPT mit 73 % die berufliche Nutzung deutlich übersteigt. Frauen stellen inzwischen mit 52 % die Mehrheit der Nutzenden, während fast die Hälfte der untersuchten Unterhaltungen von jungen Menschen (18–25 Jahre) stammt. Der am stärksten wachsende Nutzeranteil kommt aus einkommensschwachen Ländern. Hauptnutzungsarten sind:

praktische Anleitungen (28,3 %)

Textüberarbeitung (28,1 %)

und Informationssuche (24 %).

Update vom 14.09.2025: Google deaktiviert "&num=100"-Parameter

Laut Hanns Kronenberg hat Google den num-Parameter deaktiviert. Dieser erlaubte die Anzeige von 100 Suchergebnissen auf einer Seite. Vor allem SEO-Tools, Rank-Tracker und Scraping-Systeme haben dies genutzt, um schnell alle Rankings einer Domain zu analysieren.

Mit der Deaktivierung können nun nur noch die Top-10-Ergebnisse pro Anfrage abgerufen werden. Für Anbieter, die weiterhin Daten bis Position 100 benötigen, bedeutet das einen zehnfachen Mehraufwand und entsprechend höhere Kosten. Besonders betroffen sind SEO-Tool-Anbieter und Datenanalysten mit Fokus auf tiefergehende Rankings.

Brodie Clark analysiert die Folgen der Deaktivierung des Google-Parameters &num=100. Nach der Abschaltung zeigen sich laut seinem LinkedIn-Post massive Effekte:

Google Search Console (GSC) verzeichnet teils dramatische Rückgänge bei Impressionen, da viele dieser Daten offenbar von Bot-Abfragen (Rank-Tracker) stammten.

Die bisherige Erklärung des „Great Decoupling“ (starke Impressionen durch AI Overviews) wird damit infrage gestellt – womöglich waren es in Wahrheit Bot-Daten.

Tool-Anbieter wie Semrush haben Probleme, vollständige Rankings auszuspielen.

Abrufkosten steigen stark.

Google könnte damit Scraping eindämmen und die Datenqualität verbessern.

Mit der Deaktivierung des "&num=100"-Parameters könnte ein realistischeres Bild der echten, menschlichen Sichtbarkeit in den Google-Suchergebnissen entstehen. Rankingangaben jenseits der Top 10 sind damit allerdings gerade in vielen SEO-Tools unbrauchbar – die Zahlen für aktuelle Rankings und Impressionen sollten deshalb auch nicht mit Vorjahres- oder Vormonatszeiträumen verglichen werden. Wichtig ist, dass die Änderung keine Auswirkung auf den tatsächlichen Traffic hat. Es handelt sich also nur um ein Messproblem.

Henry Seyffert

Update vom 09.09.2025: Audience Overlap zwischen ChatGPT und Google

Laut aktuellen Daten von Similarweb, die von SEO-Experte Brodie Clark geteilt wurden, nutzten im August 2025 rund 95,3 % der ChatGPT-Nutzer auch Google, während nur 14,3 % der Google-Nutzer ChatGPT aufriefen.

Dies unterstreicht die anhaltende Marktdominanz von Google, trotz des rasanten Wachstums von ChatGPT.

Interessant für die SEO-Branche: Obwohl ChatGPT zunehmend als Such-Alternative wahrgenommen wird, bleibt Google klarer Hauptnutzungskanal. Gleichzeitig sei ein Rückgang des Referral-Traffics von ChatGPT zu beobachten – teils zugunsten anderer Suchdienste wie Bing.

Die ChatGPT-Nutzung wächst weiter rasant. Dennoch sind die Rufe nach "Google-Killer" verfrüht. Momentan ergänzen sich ChatGPT und Google bei der Suche nach Informationen – zumindest laut den Desktop-Daten. Auch frühere Meldungen (Beispiel1, Beispiel2, Beispiel3 und Beispiel4) zeigten, dass Google und ChatGPT koexistieren. Google bleibt bis auf Weiteres einer der wichtigsten Kanäle und sollte bei den SEO-Maßnahmen nicht vernachlässigt werden.

Alexander Beth

Update vom 08.09.2025: AI Visibility Index von Semrush vorgestellt

Semrush hat den AI Visibility Index vorgestellt – einen frei zugänglichen Benchmark, der aufzeigt, wie sichtbar Marken und Quellen in AI-generierten Suchantworten sind – insbesondere in Systemen wie ChatGPT oder dem Google AI Mode.

Der Index liefert monatlich aktualisierte Daten zu den meistgenannten Marken, Domains und Inhalten in AI-Antworten. Dabei fällt laut Aleyda Solís auf:

in ChatGPT liegen vor allem Community-basierte Quellen wie Reddit und Wikipedia auf den Plätzen 1 und 2 der Quellennennung.

im Google AI Mode hingegen liegen stärker kuratierte Informationsplattformen wie Google selbst oder YouTube auf den vorderen Plätzen.

Die Analyse basiert auf systematischen Auswertungen der Inhalte, die in AI-Suchergebnissen zitiert oder verwertet werden.

KI-Modelle setzen großes Vertrauen in Community-Quellen (z. B. Foren, Review-Seiten etc.). Neben klassischem SEO (Backlinks, Autorität etc.) spielen – wie bereits häufig erwähnt – Zitierungen eine große Rolle. Für Marken kann es sich lohnen, in solchen Quellen aktiv zu sein und hier nützliche, aktuelle Informationen zur Verfügung zu stellen.

Henry Seyffert

Update vom 06.09.2025: Neue Black-Hat SEO-Techniken

In einem aktuellen Beitrag warnt Mark Williams-Cook vor einer neuen Form von Black-Hat-Taktiken im KI-Zeitalter.

Bei der Verarbeitung von KI-Bildern werden diese in der Regel verkleinert, um Ressourcen zu sparen. Bei dieser Skalierung kann Text hinzugefügt werden, der für das menschliche Auge nicht sichtbar – aber von Google Gemini und anderen KI-Modellen erkennbar ist. Diese Technik wurde bereits missbraucht, um z. B. versteckte Prompts einzuschleusen, die sensible Aktionen auslösen.

Die potenzielle Gefahr: Bilder könnten als manipulative Inhalte genutzt und potenziell dazu verwendet werden, versteckte Nachrichten an KI-Agenten zu übermitteln und ihnen Informationen darüber zu liefern, welchen Quellen, Marken und Produkten sie vertrauen oder misstrauen sollen.

Black-Hat-SEO ist keine neue Erfindung. Vermeintlich clevere SEOs versuchen immer wieder, Lücken in neuen Technologien und Systemen auszunutzen. Was kurzfristig durch Manipulation zu Erfolgen führt, wirkt sich in der Regel jedoch langfristig negativ auf die SEO-Bemühungen aus. Gerade in Zeiten des Umbruchs sollte man hier besonders vorsichtig sein und eventuelle Shortcuts hinterfragen.

Alexander Beth

Update vom 05.09.2025: SEO als Brand-Kanal?

In einem LinkedIn-Beitrag argumentiert John Morabito, dass Click-Through-Rates (CTR) die falsche Metrik für die Bewertung von LLM-Suchergebnissen seien. LLMs wie Gemini oder ChatGPT seien nicht dafür gemacht, Traffic zu generieren, sondern Antworten direkt zu liefern – oft ohne sichtbare Links.

Der wahre Wert liegt in der Markenpräsenz innerhalb der Antworten: Sie prägen Wahrnehmung, fördern Wiedererkennung und beeinflussen spätere Suchentscheidungen. AI-SEO sollte sich daher auf Citations und mentale Sichtbarkeit konzentrieren – nicht auf kurzfristige Klicks.

Damit reiht sich John in die Riege derer ein, die einen fundamentalen Shift des SEO-Kanals beobachten.

SEO in Zeiten der KI-Suche verändert sich zunehmend zu einem Brand-Kanal – diese Erkenntnis scheint sich immer mehr zu vertiefen. Unsere Auffassung von SEO ging bereits vor der KI-Entwicklung über einen reinen Performance-Kanal hinaus. Während die klassische Suche weiterhin relevant bleibt, sind Zitierungen statt kurzfristiger Klicks das neue Ziel im KI-Zeitalter. Die größte Herausforderung besteht dabei im Monitoring dieser Entwicklung.

Henry Seyffert

Update vom 04.09.2025: LinkedIn-Inhalte in der KI-Suche

Laut einem LinkedIn-Beitrag von Tom Niezgoda, CMO bei Surfer, zeigt eine Analyse von 4,8 Mio. Mentions in AI Overviews, dass bestimmte LinkedIn-Inhalte besonders häufig zitiert werden. Am stärksten vertreten sind

Pulse-Artikel

Ratgeberverzeichnisse

normale Posts